FreeBSD — свободная UNIX-подобная операционная система, потомок AT&T Unix по линии BSD, созданной в университете Беркли. FreeBSD работает на PC-совместимых системах семейства x86, включая Microsoft Xbox, а также на DEC Alpha, Sun UltraSPARC, IA-64, AMD64, PowerPC, NEC PC-98, ARM. Готовится поддержка архитектуры MIPS.

FreeBSD разрабатывается как целостная операционная система. Исходный код ядра, драйверов устройств и базовых пользовательских программ (т. н. userland), таких как командные оболочки и т. п., содержится в одном дереве системы управления версиями (до 31 мая 2008 — CVS, сейчас — SVN). Это отличает FreeBSD от GNU/Linux — другой свободной UNIX-подобной операционной системы — в которой ядро разрабатывается одной группой разработчиков, а набор пользовательских программ — другими (например, проект GNU), а многочисленные группы собирают это всё в единое целое и выпускают в виде различных дистрибутивов GNU/Linux.

FreeBSD хорошо зарекомендовала себя как система для построения интранет- и интернет-серверов. Она предоставляет достаточно надёжные сетевые службы и эффективное управление памятью. FreeBSD широко представлена в списке веб-серверов с наибольшим временем непрерывной работы (согласно исследованию компании Netcraft).

Одежда в земле,

Хоть и праздничный день у

Ловцов улиток.

===

Мацуо Басе

FreeBSD — свободная UNIX-подобная операционная система, потомок AT&T Unix по линии BSD, созданной в университете Беркли. FreeBSD работает на PC-совместимых системах семейства x86, включая Microsoft Xbox, а также на DEC Alpha, Sun UltraSPARC, IA-64, AMD64, PowerPC, NEC PC-98, ARM. Готовится поддержка архитектуры MIPS.

FreeBSD — свободная UNIX-подобная операционная система, потомок AT&T Unix по линии BSD, созданной в университете Беркли. FreeBSD работает на PC-совместимых системах семейства x86, включая Microsoft Xbox, а также на DEC Alpha, Sun UltraSPARC, IA-64, AMD64, PowerPC, NEC PC-98, ARM. Готовится поддержка архитектуры MIPS.

FreeBSD разрабатывается как целостная операционная система. Исходный код ядра, драйверов устройств и базовых пользовательских программ (т. н. userland), таких как командные оболочки и т. п., содержится в одном дереве системы управления версиями (до 31 мая 2008 — CVS, сейчас — SVN). Это отличает FreeBSD от GNU/Linux — другой свободной UNIX-подобной операционной системы — в которой ядро разрабатывается одной группой разработчиков, а набор пользовательских программ — другими (например, проект GNU), а многочисленные группы собирают это всё в единое целое и выпускают в виде различных дистрибутивов GNU/Linux.

FreeBSD хорошо зарекомендовала себя как система для построения интранет и интернет-серверов. Она предоставляет достаточно надёжные сетевые службы и эффективное управление памятью. FreeBSD широко представлена в списке веб-серверов с наибольшим временем непрерывной работы (согласно исследованию компании Netcraft).

Опустим теорию, а на практике спустя некоторое время и количество опыта администраторы все чаще стремятся работать с системами которые были бы надежными и безотказными в которых не нужно было бы постоянно копаться чтобы, что-то там устранять и хотят стабильности и качества работы систем. Именно поэтому многие, кто в теме и не клюет на рекламные фокусы выбирает FreeBSD. Для тех кому консоль не страшна, не чуждо желание думать и ставить мозги в нужном направлении, и есть желание изучать новое тому велком то хелл и респект лично от меня.

Для начала вам необходимо скачать ISO образ или купить дистрибутив установочных дисков FreeBSD:

Будет неплохо если вы проверите контрольную сумму загруженного образа (MD5) его оригинальную сумму смотрите в директории дистрибутива под именем CHECKSUMS.MD5

Выберете дистрибутив под нужную вам архитектуру это зависит от процессора и коственно от количества RAM. Так же если вы закупаете сервер необходимо проверить его комплектующие на "Аппаратную совместимость" для удостоверения все ли у вас будет опознаваться и работать в ОС.

И так дистрибутив записан на диск теперь вы выставляете в BIOS своего сервера загрузку с диска вставляете дистрибутив и как говорил Гагарин "Поехали!"(с) Ю.А. Гагарин.

Совет: для начала не используйте реальные компьютеры и тем более не свой личный компьютер. Вы можете случайно удалить все ваши данные. Для начало воспользуйтесь ПО VirtualBox вы сможете на нем потренироваться и дальше после наработки достаточного опыта приступать к установке на реальные сервера.

До начала установки вам необходимо знать как вы назовете свою машину ее будущие сетевые настройки (IP-адрес, DNS-сервер, шлюз по умолчанию, имя домена) и для чего вы будете его использовать от этого может зависеть разбивка диска. Если вы не уверены в том, что FreeBSD поддерживает ваше оборудование то лучше заранее обратиться к списку совместимого оборудования для вашего релиза.

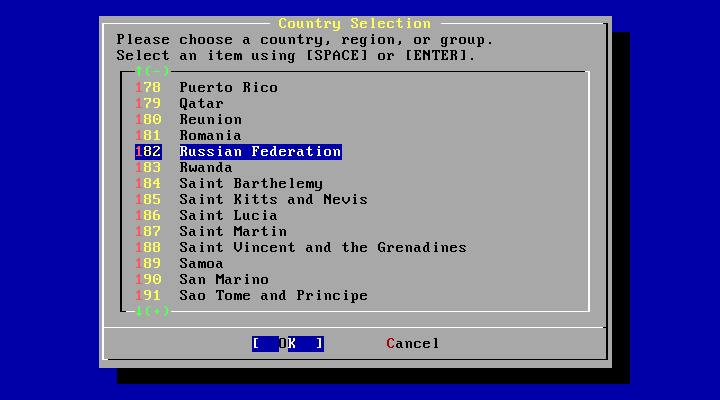

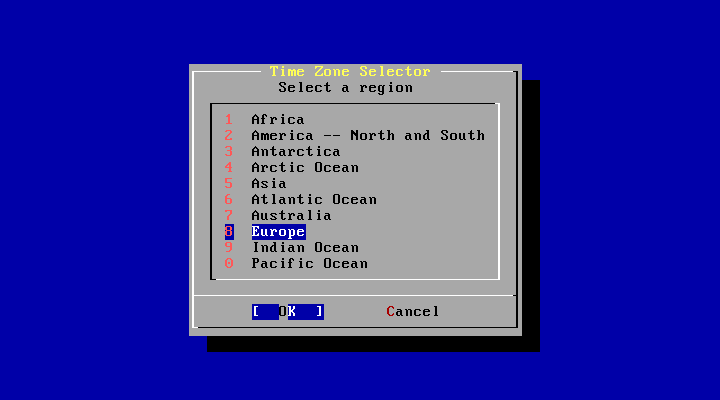

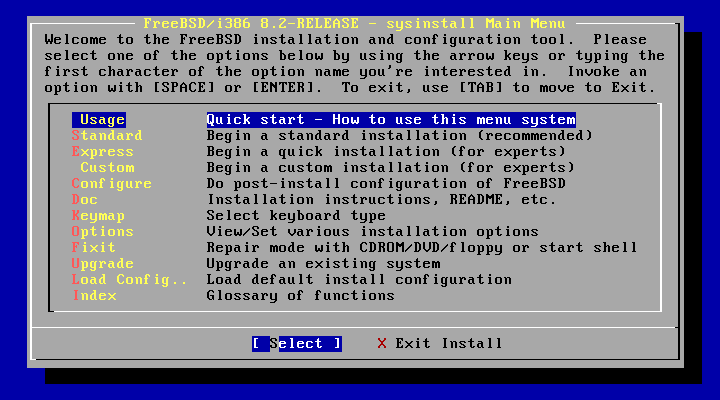

И так загрузка с диска прошла успешно и перед вами начало установки и собственно часть Sysinstall в котором вам нужно выбрать свою страну.

Совет: движение по меню — стрелками вверх-вниз или [TAB], выбор пункта - [ПРОБЕЛ] или [ENTER].

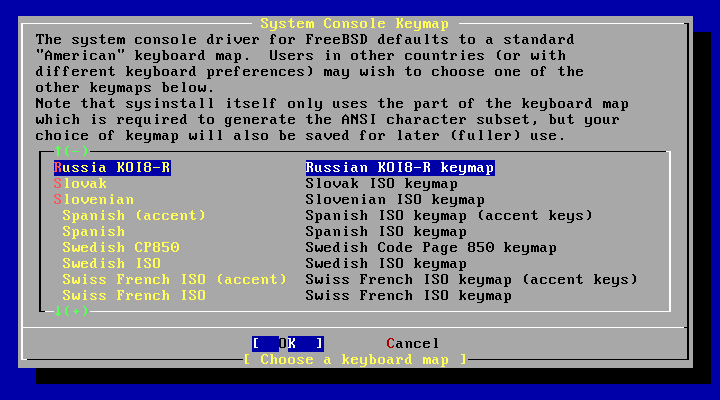

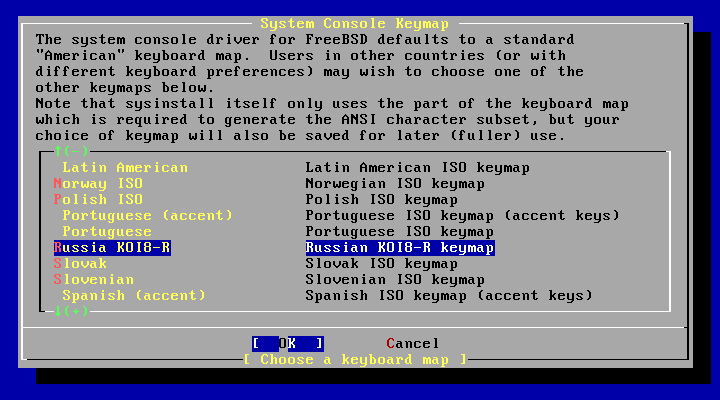

В следующем разделе вам предлагается для системной консоли выбрать раскладку клавиатуры. По умолчанию установленна "American" нам необходимо выбрать свою "Russia KOI8-R".

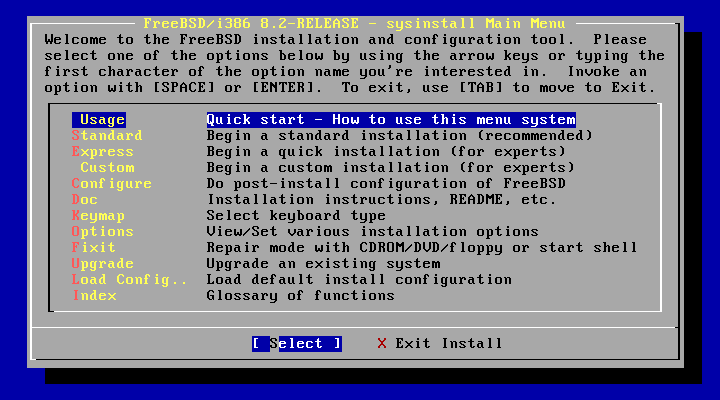

Вот мы и подошли к Sysinstall тут можно установить систему, прочитать документацию, обновить существующую систему и тд. Вам необходимо выбрать пункт "Custom" вы конечно можете конечно выбрать и пункт "Standart" который более лояльно относиться к новичкам, но в данной статье мы выберем вариант "Custom".

Как вы ведите некоторые начальные буквы подсвечены и чтобы активизировать данный пункт нужно лишь сочетать с нажатием [ALT+БУКВА].

Рассмотрим основные пункты меню:

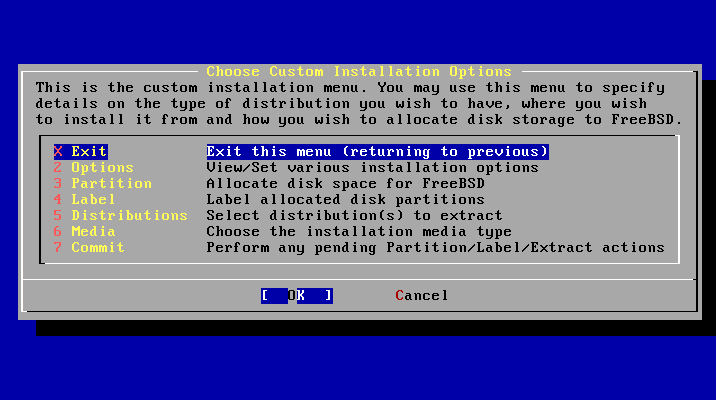

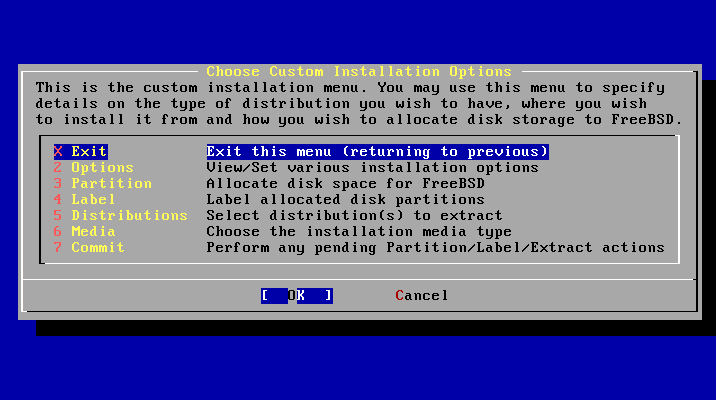

Данный раздел разбит на 7 пунктов и вы будете еще не раз возвращаться в это меню:

Начнем с 3го пункта Partition.

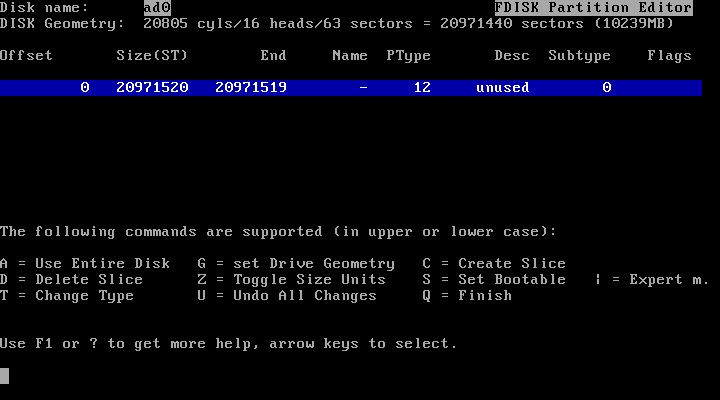

Как вы видете у меня пустой диск и я хочу использовать его весь для этого нажмем [А]. Если у вас на диске присутсвуют ненужные слайсы (slice) то выберите их (стрелки вверх-вниз) нажмите [D] и удалите ненужные и дальше снова нажмем кнопку [А]. На диске их может быть создано не более четырёх (по количеству записей в таблице разделов).

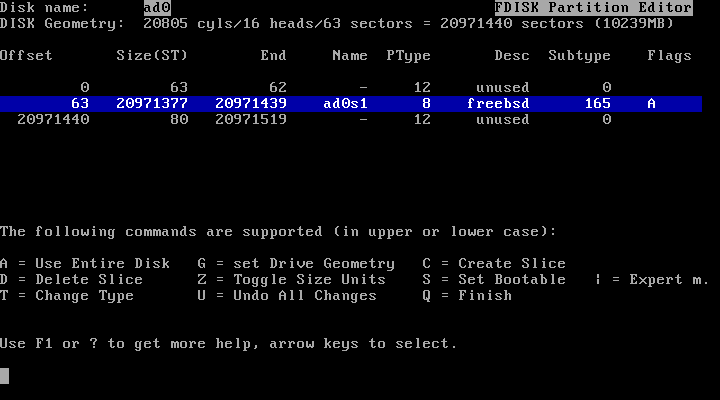

Необходимо сделать раздел freebsd загрузочным для этого выберем раздел "freebsd" (он будет между двух разделов) и нажмем [S]. В колонке Flags напротив вашего раздела появиться флаг (А).

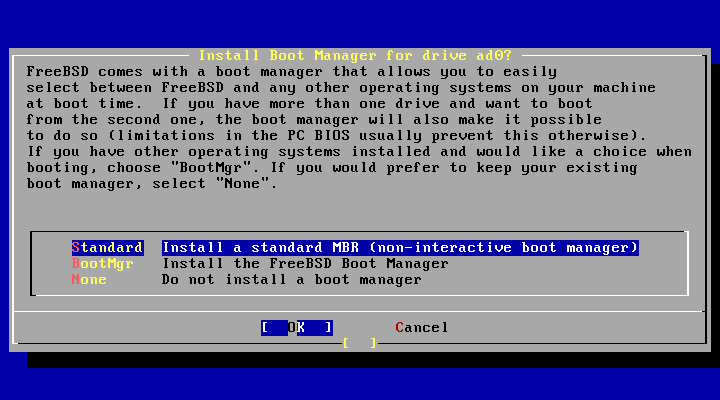

Заканчиваем разбивку диска и выходим кнопкой [Q], при этом, он спрашивает про Boot Manager мы выбираем "Standart" остальные два нужны в случае при установке и проживания FreeBSD с другими ОС на сервере.

Попадем опять в "Custom Instalation" там выбираем 4й пункта Label в котором размечаем разделы в выделенном слайсе (slice). Разделы, располагаемые внутри слайса, обозначаются буквой с A до H и могут содержать только одну ФС. Для разделов A, B, C и D существуют определенные соглашения:

Полное имя раздела состоит из имени дискового устройства, номера слайса и буквенного обозначения раздела. К примеру ad0s2a - корневой раздел слайса номер 2 ведущего (master) ATA-диска расположенным на первом контроллере.

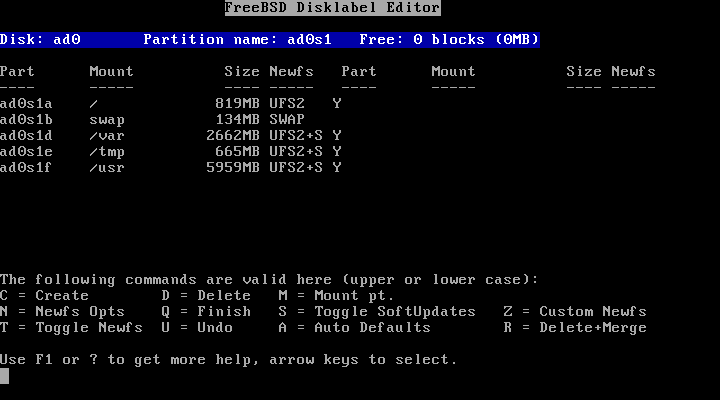

Можно нажать кнопку [А] и тогда система автоматически разобьет разделы, но это не эффективно и часто очень странно разбиваеться. Вот как раз пример такой разбивки.

Мы будем разбивать по своему усмотрению и я покажу основные этапы.

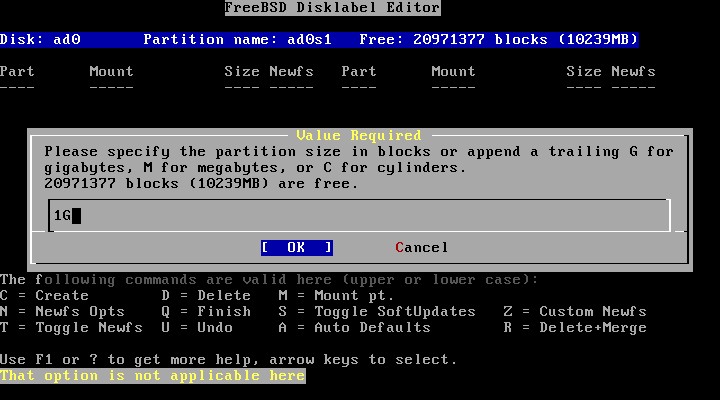

Нажмем [C] укажем нужный размер и значение, а так же укажем чем измерять указанный объем в M - Mb или G - Gb.

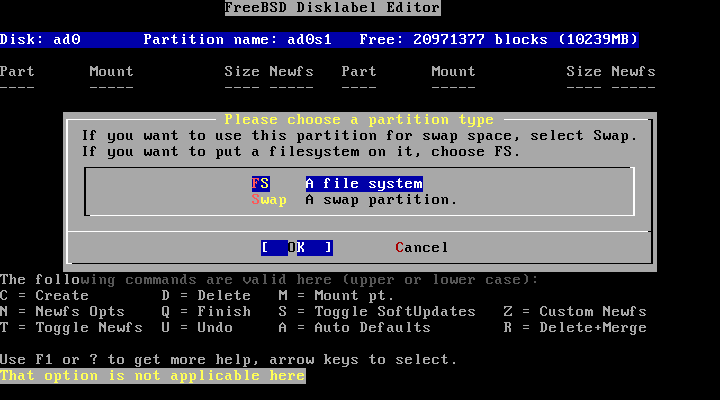

Укажем тип раздела - основной или раздел подкачки.

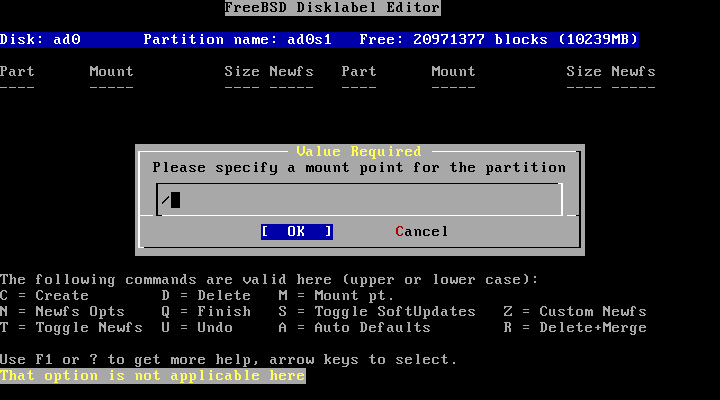

Укажем точку монтирования в данном случае я указываю корневую точку монтирования.

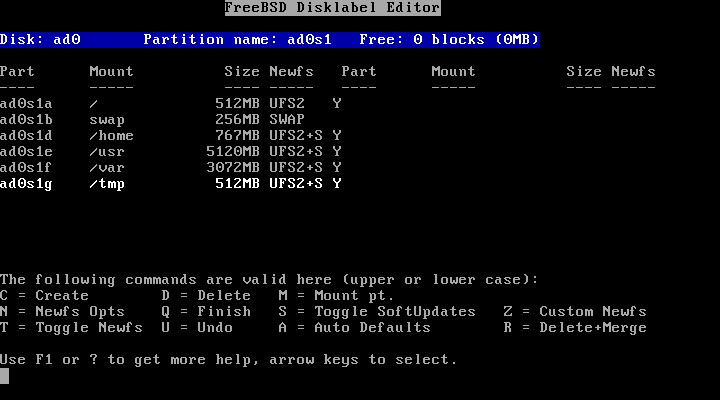

После всех манипуляций у вас не должно остаться "лишних" мегабайтов и должно разбито примерно так (размеры свои вы ставите самостоятельно):

Нажимаете [Q] завершаете работу со слайсами.

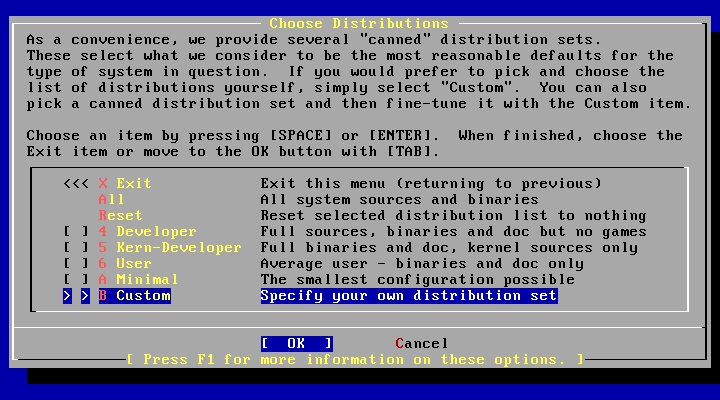

И тут опять попадаете в Custom Instalation, где выбираете пункт 5 Distributions. Теперь вам необходимо выбрать, какой именно дистрибутивный набор вам нужно установить. Выберите пункт "B Custom"

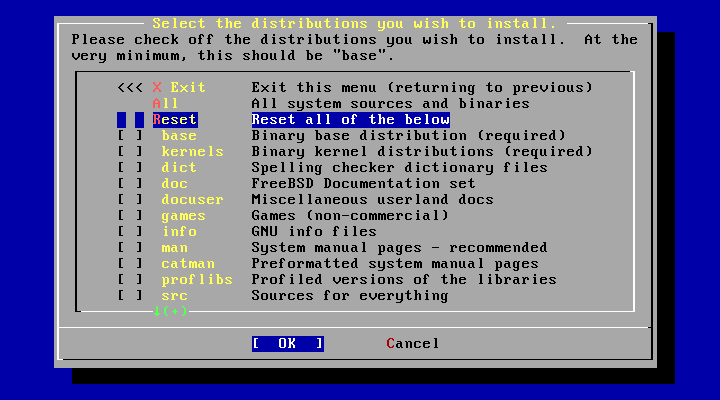

Вот целый список всего, что хотите и вам нужно указать необходимое:

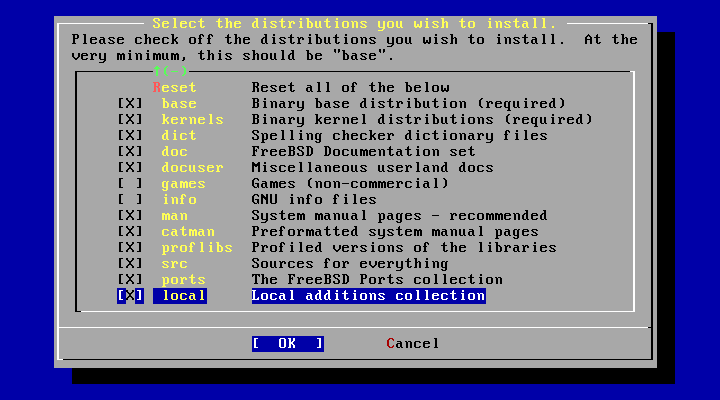

Вот примерно что должно получиться. Выбираем [OK] и попадаем опять в Custom Instalation.

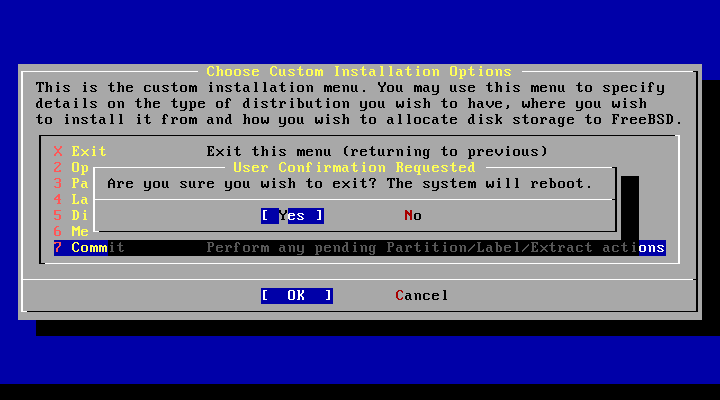

В Custom Instalation выбираете пункт 7 Commit.

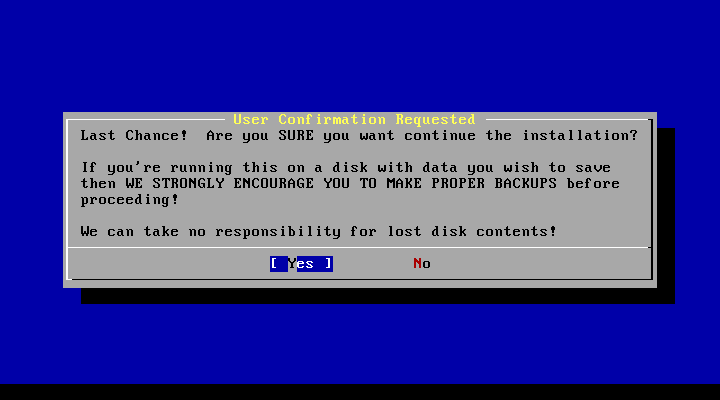

После страшного предупреждения об откачке надежды и задраивания люков приступаем к погружению.

Во время установки, проходящей на нулевой консоли [F1], доступна командная строка по [F4] и подробности установки на [F2].

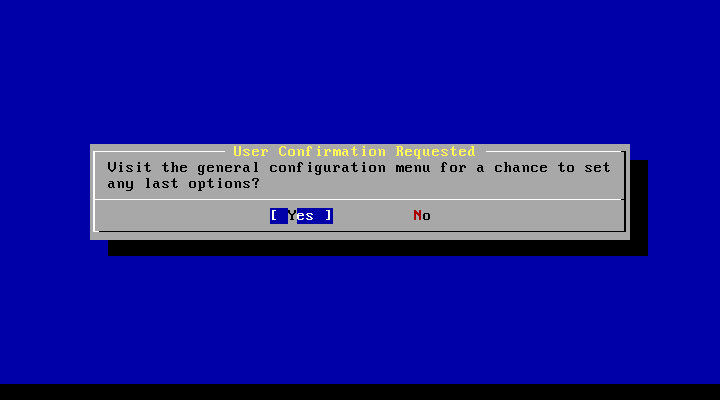

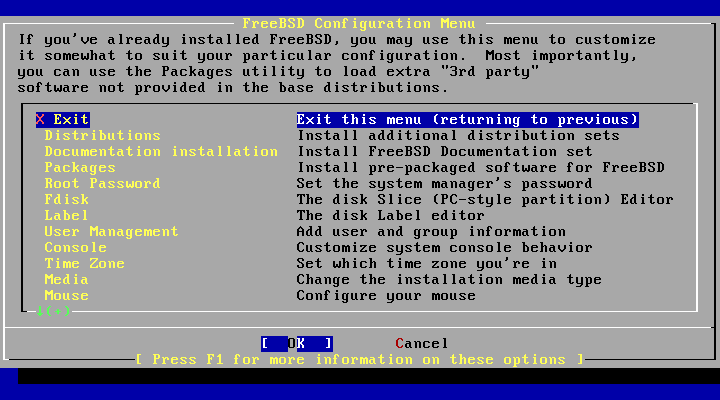

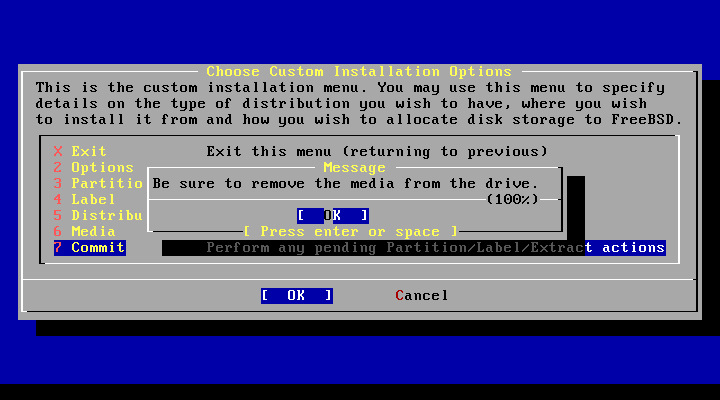

После окончания работ выходим и соглашаемся на визит в Configuration Menu.

Перед вами будет указан большой список пост-инсталяционных переменных пройдемся по основным параметрам.

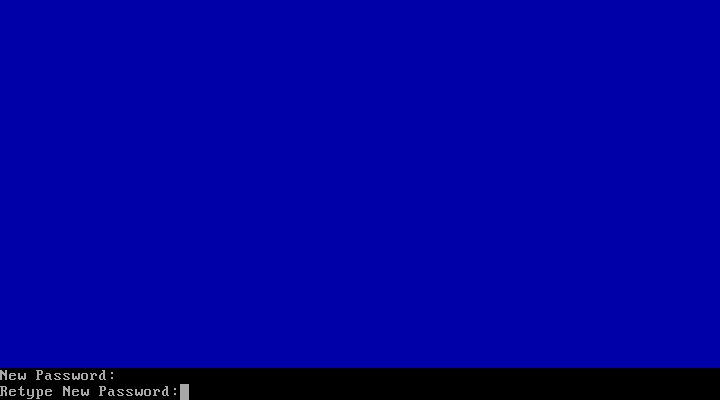

Укажем пароль root и подтверждение всё что вписываете остается невидимым такая специфика так что не бойтесь.

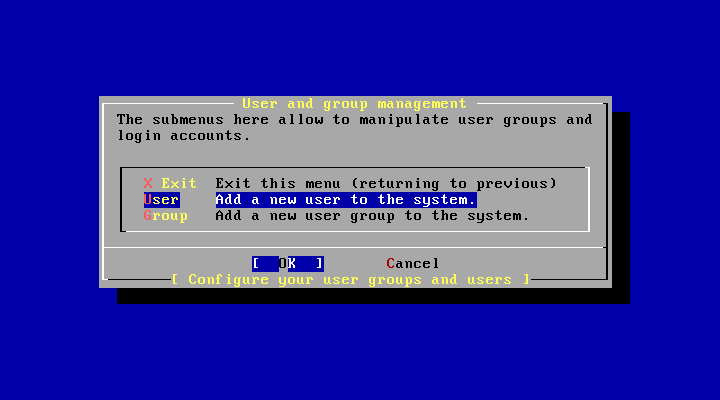

Добавим нового пользователя в систему.

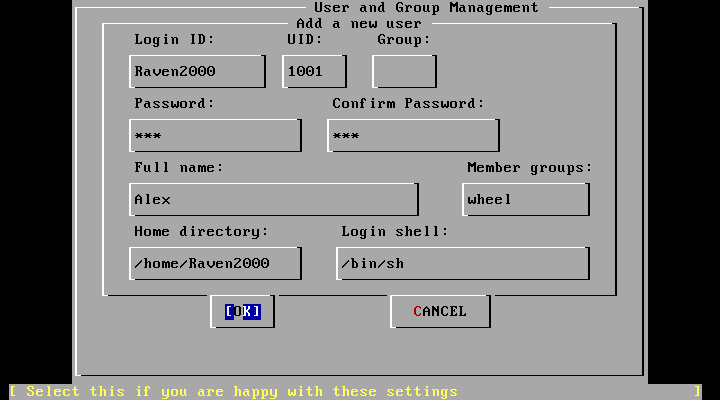

Укажем его имя, добавим в группу wheel для того чтобы он мог работать от имени root и при необходимости можете изменить shell.

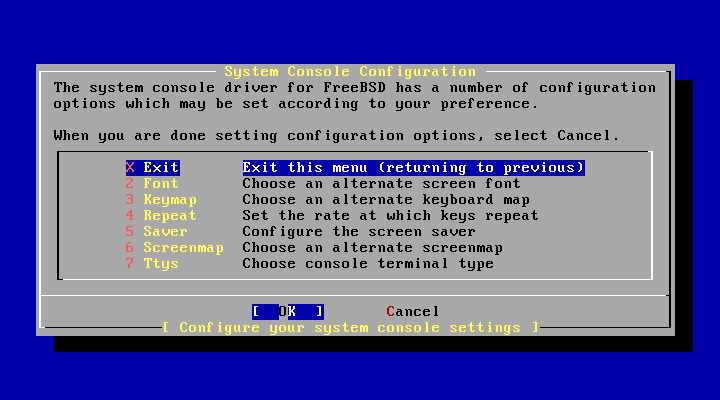

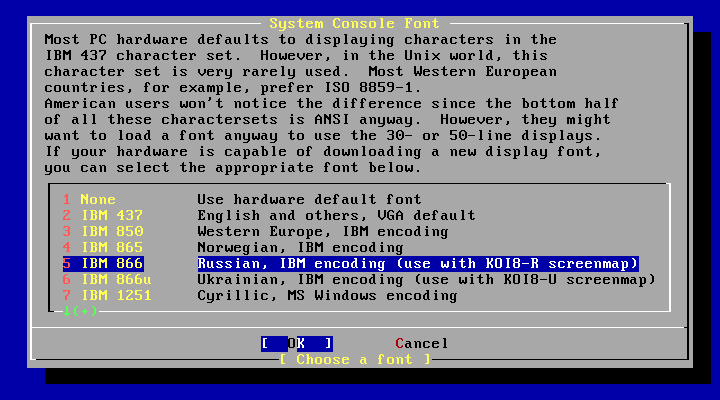

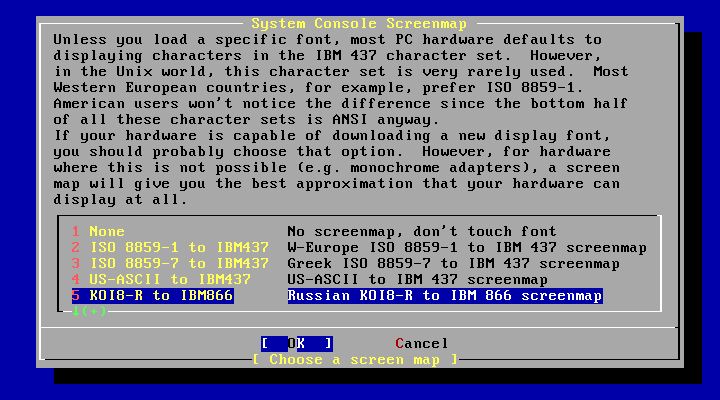

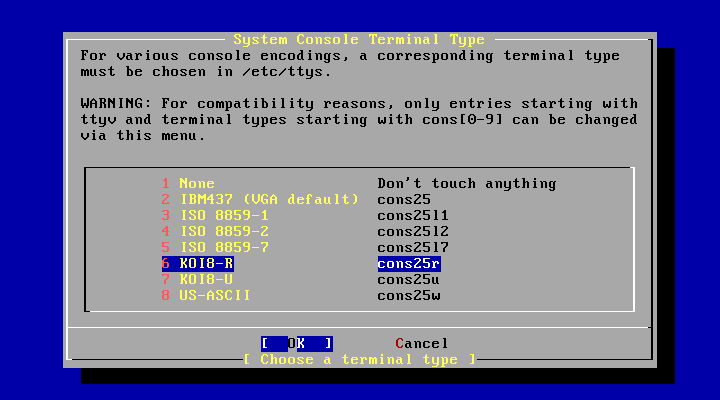

В этом меню вы указываете раскладки, шрифты, отображения и тип терминала.

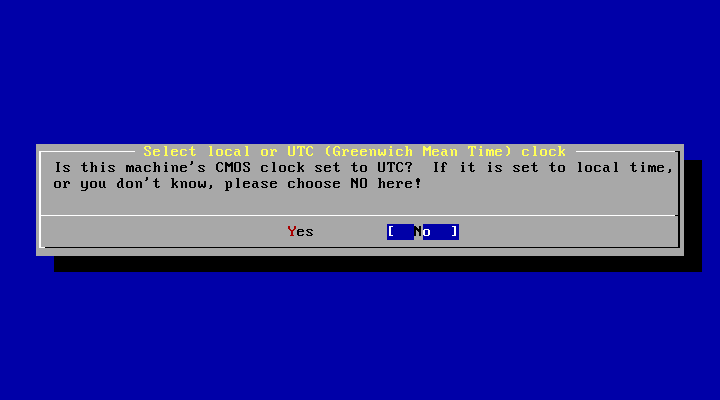

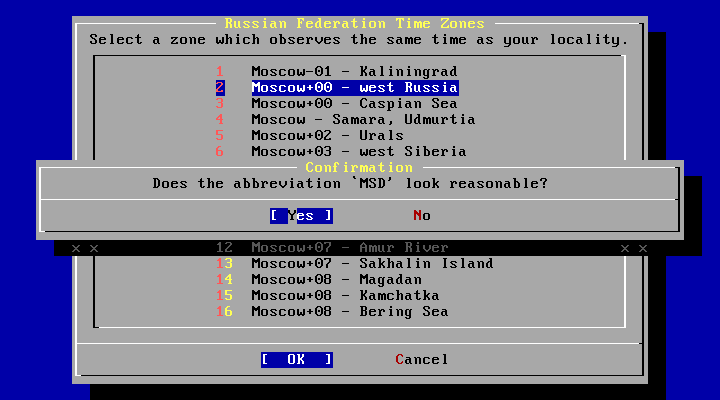

Следующи шагом вам необходимо настроить часовой пояс. На запрос о том настроенны ли CMOS-часы на UTC отвечайте "NO" затем выберете регион, страну и часовой пояс.

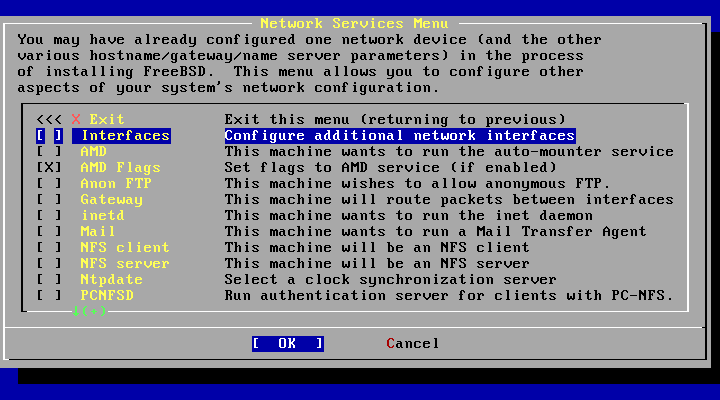

Попадаем в Configuration Menu там выбираем Network в нем заходим в Interfaces находите свой интерфейс предварительно отказавшись от IPv6 и DHCP.

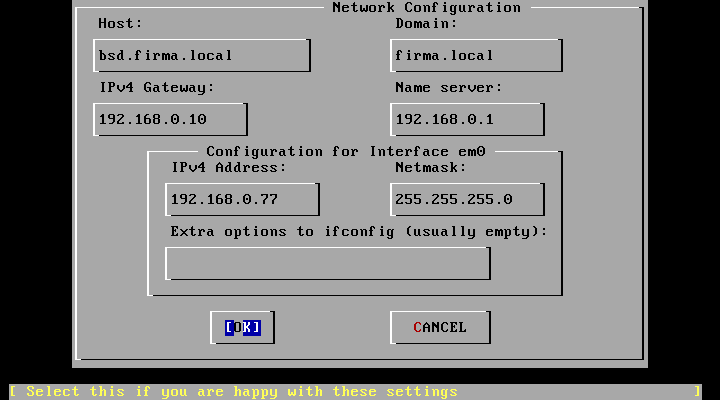

Настраиваете свою сетевую карту согласно предварительно записанным настройкам.

Не забудьте пометить SSHD в этом разделе чтобы вы могли удаленно по протоколу SSH заходить на эту машину.

Выбираетесь в основное меню и нажимаете "X Exit Instalation"

Вас переспросят действительно ли вы хотите выйти и перезагрузить машину?

А так же вежливо предложат убрать загрузочный диск. После этого перезагрузится система и все будет готово к дальнейшей работе.

Вам необходимо научиться элементарно работать с системой это можно и по хенбуку и по книгам (см "Дополнительные материалы" в конце статьи) дополнительно можете посмотреть следующие статьи.

И вы сможете сделать все что угодно если будете иметь терпение и захотите заставить работать свои мозги в нужном и правильном направлении. Удачи!

Welcome to Hell!

Много клеток хороших и разных. Под таким слоганом я занялся обустройством клеток для новых пациентов. Но немного поясню о чем будет идти речь. Мне нужны были несколько клеток для разделения программ по серверам, для тестовых работ, а так же:

И так немного истории. Jail является потомком chroot и имеет поддержку на уровне ядра и мы можем ограничивать некоторые ресурсы потребляемые клеткой, а так же привязываем её к определенному IP адресу с определенным именем хоста и определенным местом корневого каталога. Получаем изолированные процессы - клетки, в которых вы можете делать, что хотите и это не повлияет на основную систему.

Необходимо провести несколько манипуляций:

1. Укажем переменную имени к окружению.

2. Создадим домашнюю директорию по переменной.

5. Заполним каталог поддерева необходимыми двоичными файлами, библиотеками, справочниками и так далее.

6. Установим все необходимые файлы из /usr/src/etc/ и /etc в каталог клетки $D/etc/.

# Значения для всех клеток jail_enable="YES" # Включаем jail jail_interface="em0" # Сетевой интерфейс jail_devfs_enable="YES" # Монтируем devfs в клетках jail_procfs_enable="YES" # Монтируем procfs в клетках jail_set_hostname_allow="YES" # Список клеток jail_list="test" # Имя клеток через пробел для списка клеток # Значения для созданной клетки "test" jail_test_rootdir="/usr/home/jails/test.local" # Рутовая директория jail jail_test_hostname="test.local" # Имя хоста клетки jail_test_ip="192.168.0.4" # IP адрес хоста клетки #jail_test_interface="em0" # Сетевой интерфейс клетки (если нужен) #jail_test_devfs_enable="YES" # Монтируем devfs в клетке #jail_test_procfs_enable="YES" # Монтируем procfs в клетке jail_test_exec_start="/bin/sh /etc/rc" jail_test_exec_stop="/bin/sh /etc/rc.shutdown" jail_test_flags="-l -U root" # Необходимые флаги для клетки

Необходимо создать сетевые алиасы для ваших клеток. Они нужны чтобы клетки могли корректно работать в сети. Алиасы создаются на материнской системе:

bsd# cat /etc/rc.conf |grep if ifconfig_em0="inet 192.168.0.2 netmask 255.255.255.0" # Алиас для первой клетки ifconfig_em0_alias0="inet 192.168.0.4 netmask 255.255.255.255"

Для запуска всех клеток используйте:

bsd# /etc/rc.d/jail start bsd# /etc/rc.d/jail stop

bsd# /etc/rc.d/jail start test bsd# /etc/rc.d/jail stop test

Выведем список работающих клеток:

bsd# jls

JID IP Address Hostname Path

1 192.168.0.4 test.local /usr/home/jails/test.local

2 192.168.0.5 jabber.local /usr/home/jails/jabber.localЗайдем в первую клетку:

bsd# jexec 1 tcsh test#

Создадим в клетке пустой файл /etc/fstab чтобы при ее запуске не появлялось сообщение об отсутствующем файле fstab.

bsd# touch /home/jails/test.local/etc/fstab

Выключите в клетке port mapper.

bsd# cat /home/jails/test.local/etc/rc.conf |grep rpcbind rpcbind_enable="NO"

Настроим resolv.conf так, чтобы разрешение имен в клетке работало правильно. Создадим в клетке файл с нужным DNS сервером или скопируем с основной машины в клетку.

bsd# cat /home/jails/test.local/etc/resolv.conf nameserver 192.168.0.1

Запустим в клетке newaliases чтобы при запуске не появлялось сообщение от sendmail.

test# /etc/mail/ && newaliases

Отключим сетевой конфигурационный интерфейс чтобы при запуске не появлялось сообщение от ifconfig.

bsd# cat /home/jails/test.local/etc/rc.conf |grep network network_interfaces = ""

Обязательно измените пароль root в клетке (сделайте отличным от основной машины).

Создадим нового пользователя. Для этого есть штатная утилита jexec с помощью нее мы добавим нового пользователя состоящего в группе wheel [цифра это JID клетки]:

bsd# jexec 1 adduser Username: alex Full name: Alex Ign Uid (Leave empty for default): Login group [alex]: Login group is alex. Invite alex into other groups? []: wheel Login class [default]: Shell (sh csh tcsh nologin) [sh]: csh Home directory [/home/alex]: Home directory permissions (Leave empty for default): Use password-based authentication? [yes]: Use an empty password? (yes/no) [no]: Use a random password? (yes/no) [no]: Enter password: Enter password again: Lock out the account after creation? [no]: Username : alex Password : ***** Full Name : Alex Ign Uid : 1003 Class : Groups : alex wheel Home : /home/alex Home Mode : Shell : /bin/csh Locked : no OK? (yes/no): yes adduser: INFO: Successfully added (alex) to the user database. Add another user? (yes/no): no Goodbye!

Для работы с клеткой посредством ssh необходимо настроить демон sshd.

Для этого на основной машине в /etc/ssh/sshd_config укажем нужный для прослушивания IP.

bsd# cat /etc/ssh/sshd_config | grep ListenAddress #ListenAddress 0.0.0.0 ListenAddress 192.168.0.2 #ListenAddress ::

bsd# /etc/rc.d/sshd restart bsd# sockstat -l |grep sshd root sshd 1216 3 tcp4 192.168.0.4:22 *:* root sshd 978 3 tcp4 *:22 *:*

bsd# cat /home/jails/test.local/etc/rc.conf |grep sshd sshd_enable="YES"

Установите нужную временую зону в клетке.

Экспортируем существующие порты в клетку. Вы можете также скопировать их в нужную директорию или создать симлинк.

bsd# mkdir /home/jails/test.local/usr/ports bsd# mount_nullfs /usr/ports /home/jails/test.local/usr/ports bsd# cat /etc/fstab |grep jail /usr/ports /home/jails/test.local/usr/ports nullfs rw 0 0

Вы можете настроить некоторые переменные sysctl в основной системе для настройки работы клеток.

Для некоторого ограничения ресурсов клетки используйте совместно с ограничениями в /etc/login.conf ;)

Написать о самописном скрипте или о порте который может управлять клетками?

Теперь вы можете создавать и работать с клетками. Есть конечно недостатки клеток такие как отсутствие ограничений на использование ресурсов процессора или памяти без серьезной распилки и применения специальных патчей и многое другое. Но зато все работает нативно и быстро в данном случае мы добились желаемого.

Написал краткую справку об обновлении локальных и удаленных серверов в пределах одной ветки.

Сначала вам нужно обновить исходные коды системы, и мы будем использовать штатные средства операционной системы csup. Конфигурационный файл готов, его необходимо скопировать и изменить, он находится в директории:

# cd /usr/share/examples/cvsup/ # ls README gnats-supfile refuse.README www-supfile cvs-supfile ports-supfile stable-supfile doc-supfile refuse standard-supfile

Укажем нужную версию операционной системы.

В существующем конфигурационном файле стоит текущая версия.

# cat standard-supfile | grep default *default host=CHANGE_THIS.FreeBSD.org *default base=/var/db *default prefix=/usr *default release=cvs tag=RELENG_7_1 *default delete use-rel-suffix *default compress src-all

Скопируем файл и немного изменим:

# cp standard-supfile standard-supfile-RELENG_8_2 # cat standard-supfile-RELENG_8_2 | grep default *default host=CHANGE_THIS.FreeBSD.org *default base=/var/db *default prefix=/usr *default release=cvs tag=RELENG_8_2 *default delete use-rel-suffix *default compress src-all

Теперь нам необходимо синхронизировать src делается просто:

# /usr/bin/csup -h cvsup4.ru.freebsd.org -g -L 2 \ /usr/share/examples/cvsup/standard-supfile-RELENG_8_2

Когда синхронизация завершилась, приступим к обновлению системы (не забываем прочитать файл UPDATING чтобы все прошло гладко). Предупреждаю, что сначала мы будем устанавливать, ядро GENERIC и если все пройдет гладко и вы протестируете хотя бы один день сервер то можете, скомпилируйте свое ядро.

Очистим директории, от предыдущего мусора соберем мир и ядро и установим ядро:

# cd /usr/obj ;chflags -R noschg * ;rm -rf * # cd /usr/src # make -j4 buildworld # make -j4 buildkernel KERNCONF=GENERIC # make installkernel KERNCONF=GENERIC

Теперь начинаются различия обновления локального и удаленного серверов. Рассмотрим два этих варианта:

Для безопасного и корректного обновления необходимо ввести машину в single mode можно сделать двумя способами:

# shutdown -r now# shutdown nowПри удаленном обновлении вы не должны вводить машину в single mode, если вы случайно это сделаете то потеряете связь с машиной.

В виду вышесказанного необходимо действовать так:

Можно и самим остановить эти службы без перезагрузки системы.

При запуске системы в нашем случае это локальный сервер необходимо смонтировать корневой каталог и остальные разделы, а при удаленном сервере нет необходимости в монтировании каталогов. А так же запустим mergemaster для создания начальной точки работы:

# /sbin/mount -u / # /sbin/mount -a # csh # su # mergemaster -p

Установим мир и удалим старые файлы.

# cd /usr/src # make installworld # make delete-old

yes | make delete-old

Запустим mergemaster для синхронизации файлов, библиотек, конфигурационных файлов с новыми версиями.

# mergemaster -cv (c-контекстный diffs вместо унифицированного)Есть несколько вариантов управления и в низу mergemaster предлагают следующие варианты работы с текущим файлом:

При построчном сравнивании экран делится на две части, слева строки из старого файла, а справа из предлагаемого. При нажатии на "Enter" выводятся возможные варианты последующих действий:

и т.д.

После того как сравнение файла закончилось, предлагаются следующие варианты:

Бывает, что с новой версией системы появляются новые файлы, которых до этого не было. В таком случае предлагается 2 варианта:

И так сравниваются все файлы.

Когда закончите, объединять файлы перезапустите систему и удалите старые библиотеки, а так же проверьте версию системы:

# shutdown -r now # cd /usr/src/ # make delete-old-libs # uname -a FreeBSD bsd.ampul.local 8.2-RELEASE FreeBSD 8.2-RELEASE #1: Tue May 19 09:55:51 MSD 2009 Raven2000@bsd.ampul.local:/usr/obj/usr/src/sys/MYKERNEL i386

/usr/bin/csup -h cvsup4.ru.freebsd.org -g -L 2 /usr/share/examples/cvsup/ports-supfile \ && cd /usr/ports/ && make fetchindex

Обновление по крону

# crontab -l |grep csup 1 8 * * * (/usr/bin/csup -h cvsup4.ru.freebsd.org -g -L 2 \ /usr/share/examples/cvsup/ports-supfile \ && cd /usr/ports/ && make fetchindex) >/dev/null 2>&1

В. Не запускаются программы требуют старые библиотеки

О. Есть два варианта. Пересобрать ПО или установить библиотеки нужной версии ОС:

# /usr/ports/misc/compat compat3x/ compat4x/ compat5x/ compat6x/ compat7x/

Для этого нам необходимо откорректировать ядро.

Копируем ядро GENERIC под другим именем и редактируем:

cp /usr/src/sys/i386/conf/GENERIC /usr/src/sys/i386/conf/CUSTOM vi /usr/src/sys/i386/conf/CUSTOM

Добавляем следующее:

options VGA_WIDTH90 options VESA # Добавить поддержку растрового режима options SC_PIXEL_MODE # Цвет консольного шрифта options SC_NORM_ATTR="(FG_LIGHTGREEN|BG_BLACK)" # Цвет выделенного консольного шрифта options SC_NORM_REV_ATTR="(FG_YELLOW|BG_GREEN)" # Цвет сообщений ядра options SC_KERNEL_CONS_ATTR="(FG_YELLOW|BG_BLACK)" # Цвет выделенных сообщений ядра options SC_KERNEL_CONS_REV_ATTR="(FG_BLACK|BG_RED)"

Выводим список возможных разрешений:

vidcontrol -i mode

vidcontrol MODE_XXX #(XXX) номер режима

vi /etc/rc.conf

allscreens_flags="MODE_XXX"

echo 'set prompt="(%l)[%{\033[36m%}`whoami`@%{\033[1;33m%}%m:%{\033[0;32m%}%~%{\033[0m%}]%# "' >> ~/.cshrc

vi ~/.cshrc

set COLORLOGIN="%{\033[36m%}" if( `whoami` == root ) then set COLORLOGIN="%{\e[00;31m%}" endif set prompt="(%l)[$COLORLOGIN`whoami`%{\033[36m%}@%{\033[1;33m%}%m:%{\033[0;32m%}%~%{\033[0m%}]%# "

для этого надо:

vi /boot/loader.conf

autoboot_delay="4" #задержка перед запуском в секундах loader_logo="beastie" #чертёнок вместо надписи FreeBSD splash_bmp_load="YES" bitmap_load="YES" bitmap_name="/boot/splash.bmp"

sysinstall

>Configure >Console

В завершении укажем язык пользователя. pw usermod root -L russian pw usermod <user> -L russian

vi ~/.cshrc

alias ls ls -GAFfawlh #флаг G - цветной вывод команды alias df df -h #вывод в более приемлемом виде (Kb,Mb,Gb) alias halt halt -p #аналог shutdown -p now alias top top -s 1 #обновление раз в секунду alias grep grep --colour=auto #при условии установленного colorize "/usr/ports/sysutils/colorize" #alias tail "/usr/bin/tail \!* | /usr/local/bin/colorize" #alias cat "/bin/cat \!* | /usr/local/bin/colorize"

vi ~/.cshrc

setenv EDITOR ee

vi ~/.cshrc

set autolist #выводит листинг при первом нажатии TAB

set autolist = ambiguous #выводит листинг при втором нажатии TAB

Ставим zsh

pkg_add -r zsh

cd /usr/ports/shells/zsh ; make install clean

chsh -s /usr/local/bin/zsh

vi ~/.zshrc

bindkey "^[[2~" yank

bindkey "^[[3~" delete-char

bindkey "^[[5~" up-line-or-history

bindkey "^[[6~" down-line-or-history

bindkey "^[[7~" beginning-of-line

bindkey "^[[8~" end-of-line

bindkey "^[e" expand-cmd-path

bindkey "^[[A" up-line-or-search

bindkey "^[[B" down-line-or-search

bindkey " " magic-space

PROMPT=$'%{\e[1;32m%}[%{\e[1;34m%} %n@%M %/ %{\e[1;32m%}] %{\e[1;31m%}%# %{\e[0m%}'

RPROMPT=$'%{\e[1;32m%}[%{\e[1;34m%} %T %{\e[1;32m%}]%{\e[0m%}'

alias df='df -h'

alias ls='ls -GAFfawl'

alias top='top -s 1'

EDITOR=/usr/bin/ee

export EDITOR

Bacula — кроссплатформенное клиент-серверное программное обеспечение, позволяющее централизованно управлять резервным копированием, восстановлением, и проверкой данных по сети. Bacula также может работать на единственном сервере или, распределёно на нескольких, может записывать резервные копии на различные типы носителей, включая ленты, ленточные библиотеки, диски. Предлагает широкие возможности для управления хранилищами данных, облегчает поиск и восстановление потерянных или повреждённых файлов. Благодаря модульной структуре, Bacula легко масштабируемая система и может работать как в маленьких так и в крупных сетях. Дает возможность управления через CLI, GUI и веб-интерфейс.

Bacula разделена на несколько отдельных модулей это придает ей гибкости в работе:

Первое, что вы должны будете сделать это понять и описать кто, что и когда будет резервироваться. В нашем примере я буду использовать три сервера.

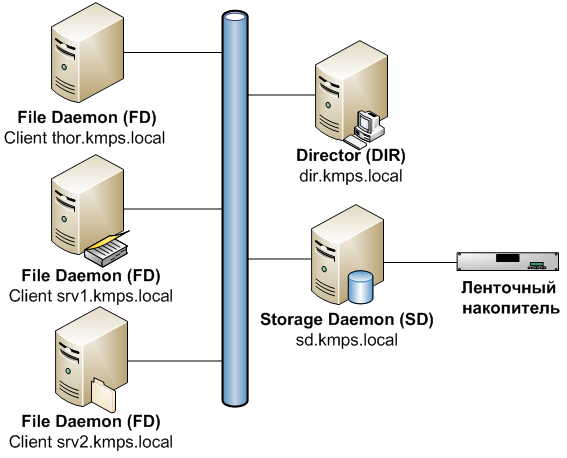

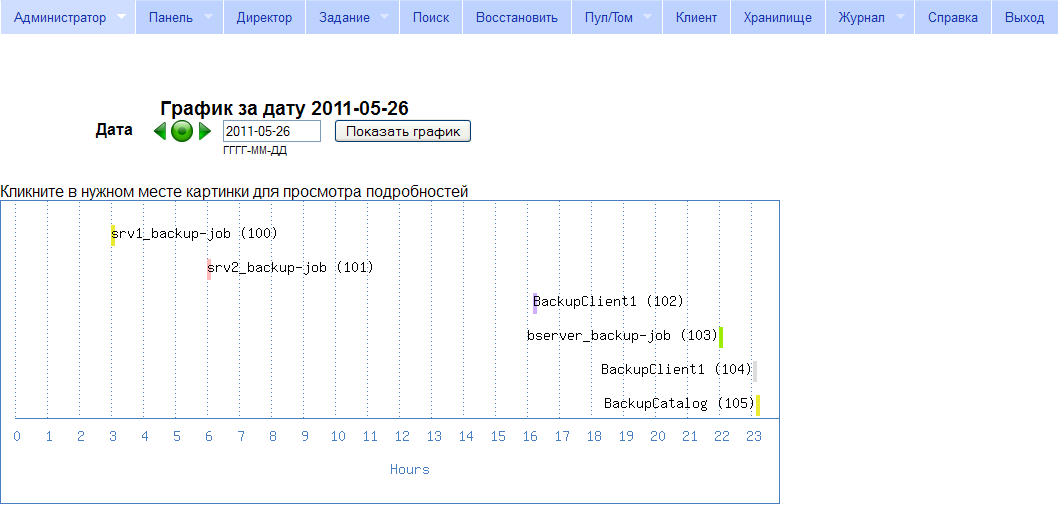

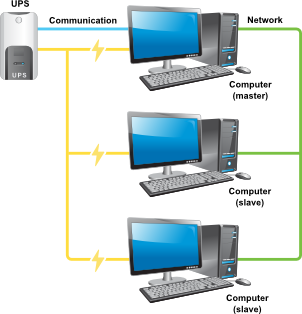

Как я сказал Bacula может быть распределена в сети и при грамотном ведении хозяйства и бюджета наша задача выглядит примерно так.

Примечание: чтобы не усложнять схему я специально убрал из неё трей-монитор, командную консоль, и БД каталога тк их можно поставить на другие машины. Пример

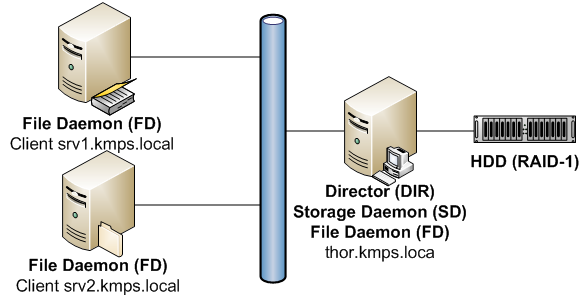

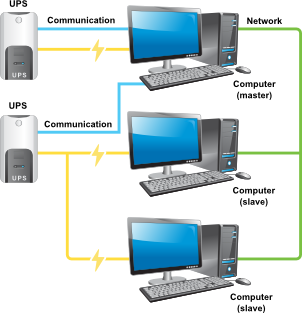

К слову сказать готовые ленты желательно переносить в другое здание (или помещение) тк от чрезвычайных случаев никто не застрахован. И вот еще я как и все вы живем в России обычно бюджет фирм на ИТ небольшой и приходиться выкручиваться самому так, что реальная схема часто выглядит так.

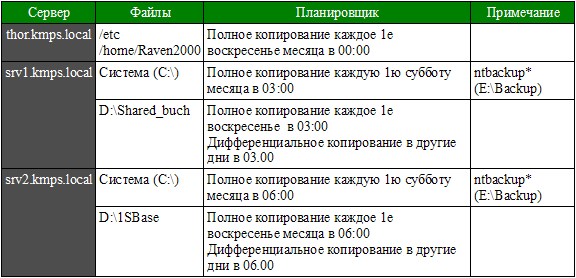

Для начала вам понадобится нарисовать простую таблицу примерно такого вида.

Так вы можете наглядно понять, что необходимо и как нужно сделать, дальше следуйте вашей схеме. В процессе схему можете дополнять и оптимизировать не забывая все документировать. Вы документируете свою работу ведь правда?

Дополнительно опишем типы резервного копирования их плюсы и минусы:

Предпочтителен Full backup но это"дорого" обходиться. Если данные не очень ценны или ресурсов мало то используйте Incremental backup. Differential backup это компромисс, но бывает что последняя копия приближается объему полного копирования так что следите за ним =). Есть еще и другие типы копирования такие как VirtualFull и Base вы можете познакомиться с ними сами.

Установка стандартна так что следуйте за белым кроликом...

# make search name=bacula-server

Port: bacula-server-5.0.3

Path: /usr/ports/sysutils/bacula-server

Info: The network backup solution (server)

Maint: dan@langille.org

B-deps: gettext-0.18.1.1 libiconv-1.13.1_1 postgresql-client-8.3.15,1

R-deps: gettext-0.18.1.1 libiconv-1.13.1_1 postgresql-client-8.3.15,1

WWW: _http://www.bacula.org/

# cd /usr/ports/sysutils/bacula-server

# make config

Options for bacula-server 5.0.3

[ ] SQLITE3 Use SQLite-3 database

[X] MYSQL Use MySQL database

[ ] POSTGRESQL Use PostgreSQL database

[ ] MTX Install mtx for control of autochanger devices

[X] NLS Native Language Support via gettext utilities

[X] OPENSSL Enable OpenSSL for encrypted communication

# make install clean

You may use the following build options (or make config):

WITH_CLIENT_ONLY=yes if you only want the file daemon.

WITH_MTX=yes if you want to use mtx instead of chio for autochanger control.

WITH_SQLITE3=yes if you want SQLite-3 as the database (not recommended).

WITH_OPENSSL=yes Enable OpenSSL for encrypted communication.

~~~

===> SECURITY REPORT:

This port has installed the following files which may act as network

servers and may therefore pose a remote security risk to the system.

/usr/local/lib/libbac.so.5

This port has installed the following startup scripts which may cause

these network services to be started at boot time.

/usr/local/etc/rc.d/bacula-sd

/usr/local/etc/rc.d/bacula-dir

If there are vulnerabilities in these programs there may be a security

risk to the system. FreeBSD makes no guarantee about the security of

ports included in the Ports Collection. Please type 'make deinstall'

to deinstall the port if this is a concern.

For more information, and contact details about the security

status of this software, see the following webpage:

http://www.bacula.org/

===> Cleaning for bacula-server-5.0.3Для работы Bacula Director ему необходима база данных для накопления и оперирования всевозможными данными о собранных резервных копиях. Такая база называется Каталог (Catalog) и храниться она в СУРБД (MySQL, Postgres). Каталогов может быть несколько, в зависимости от потребностей. Перед запуском, необходимо подготовить хотя бы один.

Cоздадим базу данных в MYSQL, например BACULA_DB, и пользователя имеющего полные права на эту базу данных.

# mysqladmin -uADMIN_USER -pADMIN_PASS create BACULA_DB # mysql -uADMIN_USER -pADMIN_PASS -e"GRANT ALL ON BACULA_DB.* TO \ BACULA_USER@localhost IDENTIFIED BY 'BACULA_USER_PASS'" BACULA_DB

# /usr/local/share/bacula/make_mysql_tables -u BACULA_USER -pBACULA_USER_PASS Creation of Bacula MySQL tables succeeded.

Необходимо создать директорию (а лучше взять новый диск для хранения резервных копий и еще лучше это использовать ленточный накопитель) куда будем писать резервные копии, и даем доступ на запись пользователю bacula и примонтируем (в моем случае) диск для бекапов:

# mkdir /home/bacula/backup # chown bacula:bacula /home/bacula/backup # mount /dev/ad6s1d /home/bacula/backup

Добавим в fstab строчку про монтирование диска (в моем случае).

# cat /etc/fstab # Device Mountpoint FStype Options Dump Pass# /dev/mirror/gm0s1b none swap sw 0 0 /dev/mirror/gm0s1a / ufs rw 1 1 /dev/mirror/gm0s1f /home ufs rw 2 2 /dev/mirror/gm0s1d /usr ufs rw 2 2 /dev/mirror/gm0s1e /var ufs rw 2 2 /dev/ad6s1d /home/bacula/backup ufs rw 2 2 /dev/acd0 /cdrom cd9660 ro,noauto 0 0 tmpfs /tmp tmpfs rw 0 0

Необходимо создать конфигурационные файлы для DIR и SD на основе шаблонов и отредактировать их в соответствии с желаемой конфигурацией.

# cd /usr/local/etc # ll |grep bacula -r--r--r-- 1 root wheel 949B 11 май 11:56 bacula-barcodes.samples -rw-r----- 1 root bacula 8,8K 11 май 11:56 bacula-dir.conf.sample -rw-r----- 1 root wheel 5,8K 11 май 11:56 bacula-sd.conf.sample # cp bacula-dir.conf.sample bacula-dir.conf # cp bacula-sd.conf.sample bacula-sd.conf

Разберем дефолтный конфигурационный файл DIR:

# cat bacula-dir.conf

#

# Дефолтный файл конфигурации Bacula Director

#

# Единственное, что должно быть изменено, это добавить одну или

# несколько имен файлов или директорий в директиве Include

# набора FileSet.

#

# Для Bacula релиза 5.0.3 (04 августа 2010) - FreeBSD 8.2-RELEASE

#

# Вы также можете изменить адрес электронной почты по умолчанию

# от root до вашего адреса. См. директивы "mail" и "operator"

# в ресурсах сообщения.

#

Director { # Определим себя

Name = thor.kmps.local-dir # Имя

DIRport = 9101 # Порт который слушает DIR

QueryFile = "/usr/local/share/bacula/query.sql"

WorkingDirectory = "/var/db/bacula" # Рабочий каталог

PidDirectory = "/var/run"

Maximum Concurrent Jobs = 1 # Максимальное количество

# параллельных заданий. Не рекомендуется

# одновременно записывать

# несколько заданий в один пул.

Password = "SECRET" # Пароль для анонимной консоли (фулл контрол)

Messages = Daemon # Набор настроек для отправки сообщений

}

JobDefs { # Дефолтное задание

Name = "DefaultJob" # Имя задания

Type = Backup # Тип (backup, restore и т.д.)

Level = Incremental # Уровень бэкапа (Full, Incremental, Differential и тп)

Client = thor.kmps.local-fd # Имя клиента

FileSet = "Full Set" # Набора файлов для сохранения.

Schedule = "WeeklyCycle" # Расписание

Storage = File # Файловое хранилище

Messages = Standard # Поведение уведомлений

Pool = File # Пул, куда будем писать бэкапы

Priority = 10 # Приоритет. Давая заданиям приоритеты

# от 1 (max) до 10 (min), можно регулировать

# последовательность выполнения.

Write Bootstrap = "/var/db/bacula/%c.bsr" # Файл хранит информацию откуда извлекать

# данные при восстановлении

}

# Определим основные ночные сохранения заданий резервного копирования

# По умолчанию, работа резервного копирование будет на диске в /tmp

Job {

Name = "BackupClient1"

JobDefs = "DefaultJob"

}

#Job {

# Name = "BackupClient2"

# Client = thor.kmps.local2-fd

# JobDefs = "DefaultJob"

#}

# Резервное копирование каталога базы данных (после ночных сохранений)

Job {

Name = "BackupCatalog"

JobDefs = "DefaultJob"

Level = Full

FileSet="Catalog"

Schedule = "WeeklyCycleAfterBackup"

# Это создает копию ASCII из каталога

# Аргументы make_catalog_backup.pl являются:

# make_catalog_backup.pl <catalog-name>

RunBeforeJob = "/usr/local/share/bacula/make_catalog_backup.pl MyCatalog"

# Это удаляет копию каталога

RunAfterJob = "/usr/local/share/bacula/delete_catalog_backup"

Write Bootstrap = "/var/db/bacula/%n.bsr"

Priority = 11 # после основного резервного копирования

}

#

# Стандартный шаблон восстановления, который может изменен консольной программой

# Только одна такая работа необходима для всех Работа/Клиентов/Хранилищ...

# [единственное я изменил путь к Where для клиента thor.kmps.local-fd

# это куда Bacula будет складывать восстановленные из архивов файлы]

Job {

Name = "RestoreFiles"

Type = Restore

Client=thor.kmps.local-fd

FileSet="Full Set"

Storage = File

Pool = Default

Messages = Standard

#Where = /tmp/bacula-restores

Where = /home/bacula/bacula-restores

}

# Список файлов для резервного копирования

FileSet { # Список файлов

Name = "Full Set" # Имя списка файлов

Include {

Options {

signature = MD5 # Тип сигнатур MD5\SHA1

}

#

# Поместить список файлов, вы можете предшествует 'File =', по одному на строку

# или включить внешний список:

#

# File = <file-name

#

# Обратите внимание: "/" резервное копирование всего корневого раздела.

# если у вас есть другие разделы, такие как "/usr" / или "/home"

# вероятно, вы захотите, чтобы добавить их тоже.

#

# По умолчанию это определяется, чтобы указать для Bacula бинарный

# каталог, чтобы дать набор файлов для резервного копирования на

# диск во время начального тестирования.

#

File = /usr/local/sbin

}

#

# Если вы сохраняете корневой каталог, следующие два исключения

# файлов могут быть полезны

#

Exclude { # Исключения

File = /var/db/bacula ##Исключаемые директории

File = /tmp ##

File = /proc ##

File = /tmp ##

File = /.journal ###Исключаемые файлы

File = /.fsck ###

}

}

#

# Когда делать резервные копии, полную резервную копию в первое

# воскресенье месяца, дифференциальный (т.е. дополнительные к полной)

# каждые остальные воскресенья, так и инкрементный в другие дни.

Schedule { # Планировщик

Name = "WeeklyCycle" # Имя планировщика

Run = Full 1st sun at 23:05 # Запуск полного бекапа в..

Run = Differential 2nd-5th sun at 23:05 # Запуск диф. бекапа в..

Run = Incremental mon-sat at 23:05 # Запуск инк. бекапа в..

}

# Этот график для каталога. Он запускается после WeeklyCycle

Schedule {

Name = "WeeklyCycleAfterBackup"

Run = Full sun-sat at 23:10

}

# Это резервное копирование каталога Bacula [изменил из-за БД имя]

FileSet {

Name = "Catalog"

Include {

Options {

signature = MD5

}

#File = "/var/db/bacula/bacula.sql"

File = "/var/db/bacula/BACULA_DB.sql"

}

}

Client {

Name = thor.kmps.local-fd # Имя клиента

Address = thor.kmps.local # Адрес

FDPort = 9102 # Порт на котором клиент сидит

Catalog = MyCatalog # Каталог в MySQL

Password = "SECRET" # пароль для FileDaemon

File Retention = 30 days # 30 дней - период, на протяжении

# которого в каталоге будет храниться

# инфа о файлах этого клиента

Job Retention = 6 months # 6 месяцев - тоже, но про задания

AutoPrune = yes # Удаление истекших заданий/файлов

}

#

# Второй клиент (File Services) для резервного копирования

# Вы должны изменить имя, адрес и пароль, прежде чем использовать

#

#Client {

# Name = thor.kmps.local2-fd

# Address = localhost2

# FDPort = 9102

# Catalog = MyCatalog

# Password = "SECRET" # пароль для FileDaemon 2

# File Retention = 30 days # 30 дней

# Job Retention = 6 months # 6 месяцев

# AutoPrune = yes # Удаление истекших заданий/файлов

#}

# Определение устройства хранения файлов

Storage {

Name = File # Имя. Используется в определениях job

# Не используйте здесь "localhost"

Address = thor.kmps.local # Здесь использовать полное имя

SDPort = 9103 # Порт SD

Password = "SECRET" # Пароль к SD

Device = FileStorage # Устройство. Должно быть определено

# в настройках секции Device сервера хранения

Media Type = File # Файл, диск, лента

}

# Определение DDS ленточного устройство хранения данных

#Storage {

# Name = DDS-4

# Не используйте здесь "localhost"

# Address = localhost # Здесь использовать полное имя

# SDPort = 9103 # Порт SD

# Password = "SECRET" # пароль для Storage daemon

# Device = DDS-4 # должен быть таким же, как Device в Storage daemon

# Media Type = DDS-4 # должен быть таким же, как MediaType в Storage daemon

# Autochanger = yes # включить для авточейнджера устройства

#}

# Определение 8мм устройства хранения ленты

#Storage {

# Name = "8mmDrive"

# Не используйте здесь "localhost"

# Address = localhost

# SDPort = 9103

# Password = "SECRET"

# Device = "Exabyte 8mm"

# MediaType = "8mm"

#}

# Определение DVD накопителя

#Storage {

# Name = "DVD"

# Не используйте здесь "localhost"

# Address = localhost

# SDPort = 9103

# Password = "SECRET"

# Device = "DVD Writer"

# MediaType = "DVD"

#}

# Службы общего каталога

Catalog {

Name = MyCatalog

# Раскомментируйте следующую строку, если вы хотите использовать dbi драйвера

# dbdriver = "dbi:mysql"; dbaddress = 127.0.0.1; dbport =

dbdriver = "dbi:mysql"; dbaddress = 127.0.0.1; dbport = 3306

dbname = "kmps_bacula"; dbuser = "kmps_bacula"; dbpassword = "PASSWORD"

}

# Умеренная доставки сообщения - отправить большинство сообщений на адрес

# электронной почты и консоль

Messages {

Name = Standard

#

# ПРИМЕЧАНИЕ! Если вы отправляете на два почтовых адреса или более

# адресов электронной почты, необходимо будет заменить %r в поле

# (-f части) с одиним действительным адресом электронной почты в

# обоих mailcommand, так и operatorcommand. Что это делает, он

# устанавливает адрес электронной почты, сообщения электронной почты

# будет отображаться в поле «ОТ», который является по умолчанию

# такое же письмо, как они его передали. Однако если вы отправляете

# сообщение на более чем один адрес, то вам придется вручную,

# установить адреса на один адрес. Например, «no-reply@mydomain.com»,

# лучше так, что стремится сказать (большинству) людей, которые

# его получат с автоматизированного источника рассылки сообщений.

mailcommand = "/usr/local/sbin/bsmtp -h localhost -f \"\(Bacula\) \<%r\>\" /

-s \"Bacula: %t %e of %c %l\" %r"

operatorcommand = "/usr/local/sbin/bsmtp -h localhost -f \"\(Bacula\) \<%r\>\" /

-s \"Bacula: Intervention needed for %j\" %r"

mail = root@localhost = all, !skipped

operator = root@localhost = mount

console = all, !skipped, !saved

#

# ВНИМАНИЕ! Переменная указанная ниже создаст файл, который вам

# нужно будет ротировать newsyslog'ом Однако, он также будет

# держать все ваши сообщения, если они просматриваются

# с консоли.

append = "/var/db/bacula/log" = all, !skipped

catalog = all

}

#

# Доставка сообщений для демона сообщений (не работы).

Messages {

Name = Daemon

mailcommand = "/usr/local/sbin/bsmtp -h localhost -f \"\(Bacula\) \<%r\>\" /

-s \"Bacula daemon message\" %r"

mail = root@localhost = all, !skipped

console = all, !skipped, !saved

append = "/var/db/bacula/log" = all, !skipped

}

# Определение пула по умолчанию

# Pool - отдельное описание для каждого набора томов (лент, DVD, файлов)

# используется при описании задания для указания пула из которого

# должен быть взят том. В каждый пул может входить несколько томов.

Pool { # Пул

Name = Default # Имя пула

Pool Type = Backup # Тип пула

Recycle = yes # Bacula может автоматически рециркулировать тома (Volumes)

AutoPrune = yes # Удалять из каталога записи о файлах и

# заданиях, срок хранения которых истёк в

# соответствии с Volume Retention,

# при поиске доступного на запись тома.

Volume Retention = 365 days # Через один год

}

# Определения пула файлов

Pool { # Пул

Name = File # Имя пула

Pool Type = Backup # Тип пула

Recycle = yes # Bacula может автоматически рециркулировать тома (Volumes)

AutoPrune = yes # Удаление истекших томов (Volumes)

Volume Retention = 365 days # через один год

Maximum Volume Bytes = 50G # Ограничение размера тома

Maximum Volumes = 100 # Ограничить количество томов в пуле

}

# Определения пула Scratch

# Scratch зарезервировано для пула запасных том - при необходимости

# система самостоятельно переводит том из него в требуемый пул

Pool {

Name = Scratch

Pool Type = Backup

}

#

# Ограниченная консоль, используемая в трей мониторе для получения

# статуса директора DIR

#

Console {

Name = thor.kmps.local-mon

Password = "SECRET"

CommandACL = status, .status

}

# Свои конфигурационные файлы

#@/usr/local/etc/client_schedule.conf

@/usr/local/etc/client_thor.conf

@/usr/local/etc/client_srv1.conf

@/usr/local/etc/client_srv2.confЧто бы эффективно управлять системой резервного копирования, нужно как следует подумать и попрактиковаться, пока не придет понимание как эта система работает. В конфигурационном файле вы должны описать к примеру работу для одного клиента несколькими переменными такими как Job, Storage, Pool, Client, FileSet, Schedule. Каждой переменной присваивается понятное имя и далее в Job указываются необходимые имена переменных чтобы это было законченной задачей и могло работать согласно вашим указаниям. Рабочий клиент состоит из 6ти элементов:

Примечание: Все переменные вы можете использовать в различных комбинациях указав нужное имя в нужной работе к примеру Schedule с именем Weekly_1st можете использовать в разных работах которым необходимо одинаковое время и периодичность работ.

Создадим дополнительные конфигурационный файлы для трех серверов и включим их в bacula-dir.conf.

Клиент THOR

# cat client_thor.conf

# Клиент Thor

# Создаем задание thor_backup-job и указываем ресурсы.

Job {

Name = "thor_backup-job" # Имя задания

Type = Backup # Тип (backup, restore и т.д.)

Level = Full # Уровень бэкапа

Client = thor-fd # Имя клиента

FileSet = "thor-fileset" # Набора файлов для сохранения.

Schedule = "Month-1hrs-sun" # Расписание

Storage = backup-disk1 # Файловое хранилище

Messages = Daemon # Поведение уведомлений

Pool = thor-pool # Пул, куда будем писать бэкапы

Priority = 10 # Приоритет. Давая заданиям приоритеты

# от 1 до 10, можно регулировать

# последовательность выполнения.

Write Bootstrap = "/var/db/bacula/thor_backup-job.bsr"

}

# Определяем список резервируемых файлов

FileSet {

Name = "thor-fileset" # Имя списка

Include {

Options {

signature = MD5

}

File = /etc # Указываем каталоги, который будем бэкапить

File = /home/Raven2000

}

Exclude { # Исключим пару каталогов

File = /home/Raven2000/www/tmp

File = /home/Raven2000/www/log

}

}

# Pool - описание набора устройств хранение

# В каждый пул будет входить несколько томов. Регулировать, в какой конкретно

# том бакула будет писать задание нельзя. Я хотел, чтобы каждое задание

# у меня писалось в отдельный файл, поэтому на каждый backup job у меня

# будет отдельный пул.

Pool {

Name = thor-pool # Имя пула

Pool Type = Backup # Тип пула

Recycle = yes # Автоматически менять тома.

AutoPrune = yes # Автоматическое удаление из БД заданий с

# истекшим сроком годности.

Volume Retention = 365 days # Срок, по истечении которого тома будут

# удаляться из пула.

Maximum Volume Bytes = 50G # Ограничение размера тома

Maximum Volumes = 100 # Ограничить количество томов в пуле

Label Format = "thor-" # Шаблон для создания имени тома при

# автоматическом создании метки тома

# требует указания Label Media в

# настройках сервера хранения.

Recycle Oldest Volume = yes # Удаляем старые копии при нехватке места для новых

}

# Определения клиентов

Client {

Name = thor-fd # Имя клиента

Address = thor.kmps.local # адрес

FDPort = 9102 # Порт, на котором клиент нас ждет

Catalog = "MyCatalog" # Каталог в MySQL

Password = "SECRET" # Пароль к клиенту

File Retention = 30 days # Период, на протяжении которого в каталоге

# будет храниться инфа о файлах этого клиента

Job Retention = 3 months # То же, только о заданиях этого клиента

AutoPrune = yes # Удалять из каталога

# данные о файлах и заданиях, срок хранения

# которых истек.

}

# Определения файловых хранилищ.

Storage {

Name = backup-disk1 # Имя хранилища будет использоваться в

# определениях job

Address = thor.kmps.local # Адрес сервера хранения. Настоятельно не

# рекомендуется использовать localhost

SDPort = 9103 # Порт, где file storage нас ждет

Password = "SECRET" # Пароль к нему

Device = backup-disk1 # Устройство. Должно быть определено

# в настройках секции Device сервера хранения

Media Type = File # Файл, диск, лента и т.д.

}

# Планировщик

Schedule {

Name = "Month-1hrs-sun"

Run = Full 1st sun at 1:00

Run = Differential 2nd-5th sun at 1:00

Run = Incremental mon-sat at 1:00

}Клиент SRV1

# cat client_srv1.conf

# Клиент SRV1

# Создаем задание srv1_backup-job и указываем ресурсы.

Job {

Name = "srv1_backup-job"

Type = Backup

Level = Full

Client = srv1-fd

FileSet = "srv1-fileset"

Schedule = "Month-1hrs-sun-srv1"

Storage = File-SRV1

Messages = Daemon

Pool = srv1-pool

Priority = 10

Write Bootstrap = "/var/db/bacula/srv1_backup-job.bsr"

}

FileSet {

Name = "srv1-fileset"

Enable VSS = YES # Использовать Volume Shadow Copy Service (VSS) для клиента Win32

# VSS позволяет Bacula копировать открытых файлы

Include {

Options {

compression = GZIP # Сжатие производится на стороне клиента пофайлово в один поток

signature = MD5 # Тип сигнатур MD5\SHA1

portable = no # переносимый формат сохраняет не все атрибуты NTFS

noatime = yes # Позволяет читать файлы без изменения времён atime и ctime

checkfilechanges = yes # Выдаётся предупреждение, если размер или время

# модификации файла изменяется при резервном копировании

Ignore Case = yes # Игнор-ть регистр букв при сопост-и шаблонов и рег-х выражений

wildfile = "*.avi" # Шаблон

wildfile = "*.wmv" # Шаблон

wildfile = "*.mp3" # Шаблон

wildfile = "pagefile.sys" # Шаблон

wildfile = "hiberfil.sys" # Шаблон

wilddir = "System Volume Information" # Шаблон

wilddir = "TEMP" # Шаблон

exclude = yes # Подошедшие под шаблоны файлы исключаются из списка

}

File = "D:/Shared_buch" # Что резервируем

File = "E:/Backup/Windows" # Что резервируем

}

}

Pool {

Name = srv1-pool

Pool Type = Backup

Recycle = yes

AutoPrune = yes

Volume Retention = 365 days

Maximum Volume Bytes = 50G

Maximum Volumes = 100

Recycle Oldest Volume = yes # Удаляем старые копии при нехватке места для новых

Label Format = "srv1-" # Шаблон для создания имени тома при

# автоматическом создании метки тома

# требует указания Label Media в

# настройках сервера хранения.

}

Client {

Name = srv1-fd

Address = srv1.kmps.local

FDPort = 9102

Catalog = MyCatalog

Password = "QbTQzNv/823/spZGTu4buOxFuKT/tiBfg+ZlESr3R1lU"

File Retention = 30 days

Job Retention = 6 months

AutoPrune = yes

}

Storage {

Name = File-SRV1

Address = thor.kmps.local

SDPort = 9103

Password = "SECRET"

Device = FileStorage-srv1

Media Type = File

}

Schedule {

Name = "Month-1hrs-sun-srv1"

Run = Full 1st sun at 3:00

Run = Differential 2nd-5th sun at 3:00

Run = Incremental mon-sat at 3:00

}Клиент SRV2

# cat client_srv2.conf

# Клиент SRV2

# Создаем задание srv2_backup-job и указываем ресурсы.

Job {

Name = "srv2_backup-job"

Type = Backup

Level = Full

Client = srv2-fd

FileSet = "srv2-fileset"

Schedule = "Month-1hrs-sun"

Storage = backup-disk1

Messages = Daemon

Pool = srv2-pool

Priority = 10

Write Bootstrap = "/var/db/bacula/srv2_backup-job.bsr"

}

FileSet {

Name = "srv2-fileset"

Enable VSS = YES

Include {

Options {

compression = GZIP

signature = MD5

portable=no

noatime = yes

checkfilechanges = yes

Ignore Case = yes

wildfile = "*.avi"

wildfile = "*.wmv"

wildfile = "*.mp3"

wildfile = "pagefile.sys"

wildfile = "hiberfil.sys"

wilddir = "System Volume Information"

wilddir = "TEMP"

exclude = yes

}

File = "D:/1SBase"

File = "E:/Backup/Windows"

}

}

Pool {

Name = srv2-pool

Pool Type = Backup

Recycle = yes

AutoPrune = yes

Volume Retention = 365 days

Maximum Volume Bytes = 50G

Maximum Volumes = 100

Recycle Oldest Volume = yes # Удаляем старые копии при нехватке места для новых

Label Format = "srv2-" # Шаблон для создания имени тома при

# автоматическом создании метки тома

# требует указания Label Media в

# настройках сервера хранения.

}

Client {

Name = srv2-fd

Address = srv2.kmps.local

FDPort = 9102

Catalog = MyCatalog

Password = "MkfdcfGqds5qFoSL/W2uBG0DqIvY5bbVDWq/ZuHN39Ct"

File Retention = 30 days

Job Retention = 6 months

AutoPrune = yes

}

Storage {

Name = File-SRV2

Address = thor.kmps.local

SDPort = 9103

Password = "SECRET"

Device = FileStorage-srv2

Media Type = File

}

Schedule {

Name = "Month-1hrs-sun-srv2"

Run = Full 1st sun at 6:00

Run = Differential 2nd-5th sun at 6:00

Run = Incremental mon-sat at 6:00

}

Заметка: привыкайте делать включения в основной конфигурационный файл так будет аккуратней и проще в работе и эксплуатации.

Включим ваши конфиги в конец файла bacula-dir.conf

# cat bacula-dir.conf |grep client #@/usr/local/etc/client_schedule.conf @/usr/local/etc/client_thor.conf @/usr/local/etc/client_srv1.conf @/usr/local/etc/client_srv2.conf

Протестируем конфигурационный файл

# bacula-dir -t -d /usr/local/etc/bacula-dir.conf # bacula-dir -t -d /usr/local/etc/client_thor.conf # bacula-dir -t -d /usr/local/etc/client_srv1.conf # bacula-dir -t -d /usr/local/etc/client_srv2.conf

# vi bacula-sd.conf

#

# Дефолтный файл конфигурации Bacula Storage Daemon

#

# Для Bacula релиза 5.0.3 (04 августа 2010) — FreeBSD 8.2-RELEASE

#

# Может потребоваться изменить имя вашего накопителя в директиве

# «Archive Device» в устройство ресурсов. Если изменить имя и/или

# «Тип носителя» в ресурсе устройства, убедитесь, что bacula-dir.conf

# имеет соответствующие изменения.

#

Storage { # Определим себя

Name = thor.kmps.local-sd # Имя

SDPort = 9103 # Порт, где ждать директора

WorkingDirectory = "/var/db/bacula"

Pid Directory = "/var/run" # Собственно PID

Maximum Concurrent Jobs = 20 # Дополнительные ограничения

}

#

# Список директоров, которым разрешается связаться с Демоном хранения (SD)

#

Director {

Name = thor.kmps.local-dir # Имя директора

Password = "SECRET" # Пароль

}

#

# Ограниченный директор, используемые в трей мониторе

# для получения статуса демона хранения

#

Director {

Name = thor.kmps.local-mon # Имя директора

Password = "SECRET" # Пароль

Monitor = yes

}

#

# Примечание, список дополнительных шаблонов устройств смотрите в

# каталоге <bacula-source>/examples/devices

# Или перейдите по следующей ссылке:

# _http://bacula.svn.sourceforge.net/viewvc/bacula/trunk/bacula/examples/devices/

#

#

# Устройства записи, поддерживаемые данным Демоном хранения (SD)

# это жесткий диск, ленточный накопитель, dvd.

# Для подключения, устройства к директору в bacula-dir.conf

# должны иметь то же Name и MediaType.

#

Device {

Name = FileStorage # Имя

Media Type = File # Укажем, что будем бекапить

Archive Device = /tmp # Каталог для бекапов

LabelMedia = yes; # разрешить Bacula размечать тома

Random Access = Yes;

AutomaticMount = yes; # когда устройство открыто, читать его

RemovableMedia = no;

AlwaysOpen = no;

}

#

# Авточенджер с двумя дисками

#

#Autochanger {

# Name = Autochanger

# Device = Drive-1

# Device = Drive-2

# Changer Command = "/usr/local/share/bacula/mtx-changer %c %o %S %a %d"

# Changer Device = /dev/sg0

#}

#Device {

# Name = Drive-1 #

# Drive Index = 0

# Media Type = DLT-8000

# Archive Device = /dev/nst0

# AutomaticMount = yes; # когда устройство открыто, читать его

# AlwaysOpen = yes;

# RemovableMedia = yes;

# RandomAccess = no;

# AutoChanger = yes

# #

# # Включить команду Alert, только если у вас есть MTX пакет загрузки

# # Обратите внимание, по-видимому, в некоторых системах, tapeinfo

# # сбрасывает контроллер SCSI. Tаким образом если вы включаете это,

# # убедитесь, что он не сбрасывает ваш контроллер SCSI. У меня

# # никогда не было каких-либо проблем, и smartctl, по-видимому,

# # не вызывают таких проблем.

# #

# Alert Command = "sh -c 'tapeinfo -f %c |grep TapeAlert|cat'"

# Если у вас есть smartctl, то он имеет больше информации, чем tapeinfo

# Alert Command = "sh -c 'smartctl -H -l error %c'"

#}

#Device {

# Name = Drive-2 #

# Drive Index = 1

# Media Type = DLT-8000

# Archive Device = /dev/nst1

# AutomaticMount = yes; # когда устройство открыто, читать его

# AlwaysOpen = yes;

# RemovableMedia = yes;

# RandomAccess = no;

# AutoChanger = yes

# # Включить команду оповещения, только если у вас есть MTX пакет загрузки

# Alert Command = "sh -c 'tapeinfo -f %c |grep TapeAlert|cat'"

# Если у вас есть smartctl, то он имеет больше информации, чем tapeinfo

# Alert Command = "sh -c 'smartctl -H -l error %c'"

#}

#

# Linux или Solaris LTO-2 ленточный накопитель

#

#Device {

# Name = LTO-2

# Media Type = LTO-2

# Archive Device = /dev/nrsa0

# AutomaticMount = yes; # когда устройство открыто, читать его

# AlwaysOpen = yes;

# RemovableMedia = yes;

# RandomAccess = no;

# Maximum File Size = 3GB

## Changer Command = "/usr/local/share/bacula/mtx-changer %c %o %S %a %d"

## Changer Device = /dev/sg0

## AutoChanger = yes

# # Включить команду оповещения, только если у вас есть MTX пакет загрузки

## Alert Command = "sh -c 'tapeinfo -f %c |grep TapeAlert|cat'"

## Если у вас есть smartctl, то он имеет больше информации, чем tapeinfo

## Alert Command = "sh -c 'smartctl -H -l error %c'"

#}

#

# Linux или Solaris LTO-3 ленточный накопитель

#

#Device {

# Name = LTO-3

# Media Type = LTO-3

# Archive Device = /dev/nrsa0

# AutomaticMount = yes; # когда устройство открыто, читать его

# AlwaysOpen = yes;

# RemovableMedia = yes;

# RandomAccess = no;

# Maximum File Size = 4GB

## Changer Command = "/usr/local/share/bacula/mtx-changer %c %o %S %a %d"

## Changer Device = /dev/sg0

## AutoChanger = yes

# # Включить команду оповещения, только если у вас есть MTX пакет загрузки

## Alert Command = "sh -c 'tapeinfo -f %c |grep TapeAlert|cat'"

## Если у вас есть smartctl, то он имеет больше информации, чем tapeinfo

## Alert Command = "sh -c 'smartctl -H -l error %c'"

#}

#

# Linux или Solaris LTO-4 ленточный накопитель

#

#Device {

# Name = LTO-4

# Media Type = LTO-4

# Archive Device = /dev/nrsa0

# AutomaticMount = yes; # когда устройство открыто, читать его

# AlwaysOpen = yes;

# RemovableMedia = yes;

# RandomAccess = no;

# Maximum File Size = 5GB

## Changer Command = "/usr/local/share/bacula/mtx-changer %c %o %S %a %d"

## Changer Device = /dev/sg0

## AutoChanger = yes

# # Включить команду оповещения, только если у вас есть MTX пакет загрузки

## Alert Command = "sh -c 'tapeinfo -f %c |grep TapeAlert|cat'"

## Если у вас есть smartctl, то он имеет больше информации, чем tapeinfo

## Alert Command = "sh -c 'smartctl -H -l error %c'"

#}

#

# FreeBSD ленточный накопитель

#

#Device {

# Name = DDS-4

# Description = "DDS-4 for FreeBSD"

# Media Type = DDS-4

# Archive Device = /dev/nsa1

# AutomaticMount = yes; # когда устройство открыто, читать его

# AlwaysOpen = yes

# Offline On Unmount = no

# Hardware End of Medium = no

# BSF at EOM = yes

# Backward Space Record = no

# Fast Forward Space File = no

# TWO EOF = yes

# IIf you have smartctl, enable this, it has more info than tapeinfo

# Alert Command = "sh -c 'smartctl -H -l error %c'"

#}

#

# Передать все сообщения директора, mount сообщения

# также отправляются на адрес электронной почты

#

Messages { # Будем отправлять все сообщения DIR

Name = Standard

director = thor.kmps.local-dir = all

}Теперь соберем свой конфигурационный файл:

# cat bacula-sd.conf | grep -v ^#

Storage {

Name = thor.kmps.local-sd

SDPort = 9103

WorkingDirectory = "/var/db/bacula"

Pid Directory = "/var/run"

Maximum Concurrent Jobs = 20

}

Director {

Name = thor.kmps.local-dir

Password = "SECRET"

}

Director {

Name = thor.kmps.local-mon

Password = "SECRET"

Monitor = yes

}

Device {

Name = FileStorage

Media Type = File

Archive Device = /home/bacula/backup

#Archive Device = /tmp

LabelMedia = yes;

Random Access = Yes;

AutomaticMount = yes;

RemovableMedia = no;

AlwaysOpen = no;

}

Device {

Name = backup-disk1

Media Type = File

Archive Device = /home/bacula/backup

LabelMedia = yes;

Random Access = Yes;

AutomaticMount = yes;

RemovableMedia = no;

AlwaysOpen = no;

}

Device {

Name = FileStorage-srv1

Media Type = File

Archive Device = /home/bacula/SRV1

LabelMedia = yes;

Random Access = Yes;

AutomaticMount = yes;

RemovableMedia = no;

AlwaysOpen = no;

}

Device {

Name = FileStorage-srv2

Media Type = File

Archive Device = /home/bacula/SRV2

LabelMedia = yes;

Random Access = Yes;

AutomaticMount = yes;

RemovableMedia = no;

AlwaysOpen = no;

}

Messages {

Name = Standard

director = thor.kmps.local-dir = all

}Протестируем

# bacula-sd -t /usr/local/etc/bacula-sd.conf

Настроим консоль

# cd /usr/local/etc

# cp bconsole.conf.sample bconsole.conf

# cat bconsole.conf

#

# Bacula User Agent (or Console) Configuration File

#

Director {

Name = thor.kmps.local-dir

DIRport = 9101

address = localhost

Password = "SECRET"

}Посмотрим, что она может и отработаем несколько операций:

# /usr/local/sbin/bconsole

Connecting to Director localhost:9101

1000 OK: thor.kmps.local-dir Version: 5.0.3 (04 August 2010)

Enter a period to cancel a command.

*help

Command Description

======= ===========

add Добавить новый том к пулу в каталоге; для

форматирования тома используйте команду label

autodisplay Выдаётся извещение о наличии новых сообщений от директора

automount Лента монтируется автоматически после форматирования

командой label

cancel Отменить задание

create Создать запись Пула в БД из описания ресурса в файле

delete Удалить из каталога информацию о задании, томе

или пуле вместе со всеми зависимостями

disable Запретить автоматическое планирование работы задания

enable Разрешить автоматическое планирование работы задания

estimate Считает приблизительный объём сохраняемых данных до

сжатия, листинг дает полный список

exit Прекращение сессии Bconsole

gui Не интерактивный режим gui

help Печать справки по определенной команде

label Добавить новый том к пулу в БД и форматировать том;

предварительно может потребоваться размонтировать ленту;

если лента уже отформатирована, то требуется выполнить

команды purge и relabel

list Список объектов из каталога БД

llist Полный или длинный список, как список команд

messages вывести накопившиеся сообщения от директора

memory Вывести текущее использование памяти DIR

mount Монтировать хранилище

prune Удалить из БД информацию о файлах, заданиях или томах с

истёкшим сроком хранения и всё с нею связанное

purge Очистка записей из каталога о файлах, заданиях или томах

с истёкшим сроком хранения и всё с нею связанное

python Команда управления Python

quit Прекращение сессии Bconsole

query Запрос каталога

restore Восстановить файлы

relabel Заново отформатировать старый том (должен быть в

состоянии Purged или Recycle)

release перемотать ленту (перед следующим использованием

заново прочесть метку)

reload Перечитать заново конфигурационный файл bacula-dir.conf

run Запустить задание\работу

status Отчет о состоянии

setdebug Устанавить уровень отладки

setip Установить новый адрес клиента - если рзрешено

show Показать текущее значение ресурсов файла настройки

sqlquery Использование SQL для запроса каталога

time Показать текущее временя

trace Включение / выключение трассировки в файл

unmount Размонтирование хранилища

umount Размонтировать - для старых Unix парней, см. unmount =)

update Обновить информацию томов, пула или статистики

use Использовать каталог xxx

var Подстановка переменных

version Показать версию DIR

wait Ждать завершения задания

В режиме ввода команд, введите точку что бы отменить командный режим

Вам сообщение.Добавим новый том и отформатируем его (это при условии что вы не выставили в Pool, Label Format = "ИМЯ_ТОМА" при этом том автоматически форматируется и добавляется). Для этого выберем нужный SD (backup-disk1) укажем название Тома (как он будет сохраняться на HDD) и выберем нужный Пул.

# bconsole

Connecting to Director localhost:9101

1000 OK: thor.kmps.local-dir Version: 5.0.3 (04 August 2010)

Enter a period to cancel a command.

*label

Automatically selected Catalog: MyCatalog

Using Catalog "MyCatalog"

The defined Storage resources are:

1: File

2: backup-disk1

3: File-SRV1

4: File-SRV2

Select Storage resource (1-4): 3

Enter new Volume name: srv1_volume

Defined Pools:

1: Default

2: Scratch

3: thor-pool

4: File

5: srv2-pool

6: srv1-pool

Select the Pool (1-6): 6

Connecting to Storage daemon File-SRV1 at thor.kmps.local:9103 ...

Sending label command for Volume "srv1_volume" Slot 0 ...

3000 OK label. VolBytes=213 DVD=0 Volume="srv1_volume" Device="FileStorage-srv1"

(/home/bacula/SRV1)

Catalog record for Volume "srv1_volume", Slot 0 successfully created.

Requesting to mount FileStorage-srv1 ...

3906 File device "FileStorage-srv1" (/home/bacula/SRV1) is always mounted.

You have messages.

*label

The defined Storage resources are:

1: File

2: backup-disk1

3: File-SRV1

4: File-SRV2

Select Storage resource (1-4): 4

Enter new Volume name: srv2_volume

Defined Pools:

1: Default

2: Scratch

3: thor-pool

4: File

5: srv2-pool

6: srv1-pool

Select the Pool (1-6): 5

Connecting to Storage daemon File-SRV2 at thor.kmps.local:9103 ...

Sending label command for Volume "srv2_volume" Slot 0 ...

3000 OK label. VolBytes=213 DVD=0 Volume="srv2_volume" Device="FileStorage-srv2"

(/home/bacula/SRV2)

Catalog record for Volume "srv2_volume", Slot 0 successfully created.

Requesting to mount FileStorage-srv2 ...

3906 File device "FileStorage-srv2" (/home/bacula/SRV2) is always mounted.

*label

The defined Storage resources are:

1: File

2: backup-disk1

Select Storage resource (1-2): 2

Enter new Volume name: thor_volume

Defined Pools:

1: Default

2: File

3: Scratch

4: thor-pool

Select the Pool (1-4): 4

Connecting to Storage daemon backup-disk1 at thor.kmps.local:9103 ...

Sending label command for Volume "thor_volume" Slot 0 ...

3000 OK label. VolBytes=213 DVD=0 Volume="thor_volume" Device="backup-disk1"

(/home/bacula/backup)

Catalog record for Volume "thor_vol", Slot 0 successfully created.

Requesting to mount backup-disk1 ...

3906 File device "backup-disk1" (/home/bacula/backup) is always mounted.Как видим создался Том thor_volume

# ll /home/bacula/backup/ total 8450 -rw-r----- 1 bacula bacula 8,2M 17 май 23:50 FileDefault -rw-r----- 1 bacula bacula 213B 18 май 14:59 thor_volume

Установим клиента на UNIX машине:

# cd /usr/ports/sysutils/bacula-client

# make config

Options for bacula-client 5.0.3

[ ] WXCONSOLE Build with wxGTK based GUI console: deprecated

[ ] SFDAEMON Build with staticly compiled file daemon

[X] NLS Native Language Support via gettext utilities

[X] OPENSSL Enable OpenSSL for encrypted communication

# make install clean

~~

################################################################################

NOTE:

Sample files are installed in /usr/local/etc:

bconsole.conf.sample, bacula-barcodes.sample, bacula-fd.conf.sample

Please read this file:

/usr/local/share/doc/bacula/ReleaseNotes

as installed by docs port for the upgrade procedure.

Read the ReleaseNotes for further information.

################################################################################

===> Running ldconfig

/sbin/ldconfig -m /usr/local/lib

===> Registering installation for bacula-client-5.0.3

===> SECURITY REPORT:

This port has installed the following files which may act as network

servers and may therefore pose a remote security risk to the system.

/usr/local/lib/libbac.so.5

This port has installed the following startup scripts which may cause

these network services to be started at boot time.

/usr/local/etc/rc.d/bacula-fd

If there are vulnerabilities in these programs there may be a security

risk to the system. FreeBSD makes no guarantee about the security of

ports included in the Ports Collection. Please type 'make deinstall'

to deinstall the port if this is a concern.

For more information, and contact details about the security

status of this software, see the following webpage:

http://www.bacula.org/

===> Cleaning for bacula-client-5.0.3# cp /usr/local/etc/bacula-fd.conf.sample /usr/local/etc/bacula-fd.conf

Разберемся что внутри:

#cat/usr/local/etc/bacula-fd.conf

#

# Дефолтный файл конфигурации Bacula File Daemon

#

# Для Bacula релиза 5.0.3 (04 августа 2010) — FreeBSD 8.2-RELEASE

#

# Тут не так много, чтобы менять здесь, за исключением, возможно,

# Имени File Daemon

#

#

#Список директоров, которым разрешено связаться с этим File Daemon

#

Director {

Name = thor.kmps.local-dir

Password = "sIad48UBgVYD2gNAh6mRWKahMFtzjwRWNjtL8p28ma3Z"

}

#

# Ограничение директора, используемого в tray-monitor,

# для получения статуса File Daemon

#

Director {

Name = thor.kmps.local-mon

Password = "GkSSv/HoUCX7Y7Pi5m62xRD0cnykZnzaYTinCqdhM8t3"

Monitor = yes

}

#

# "Глобальные" спецификации конфигурации File daemon

#

FileDaemon { # Определим FD

Name = thor.kmps.local-fd # Имя FD

FDport = 9102 # Где слушать директора

WorkingDirectory = /var/db/bacula

Pid Directory = /var/run

Maximum Concurrent Jobs = 20 # Максимальное кол-во заданий

}

# Отправить все сообщения, за исключением пропущенных файлов

# обратно Директору

Messages {

Name = Standard

director = thor.kmps.local-dir = all, !skipped, !restoredТеперь соберем свой конфигурационный файл:

# cat bacula-fd.conf | grep -v ^#

Director {

Name = thor.kmps.local-dir

Password = "SECRET"

}

Director {

Name = thor.kmps.local-mon

Password = "SECRET"

Monitor = yes

}

FileDaemon {

Name = thor.kmps.local-fd

FDport = 9102

WorkingDirectory = /var/db/bacula

Pid Directory = /var/run

Maximum Concurrent Jobs = 20

}

Messages {

Name = Standard

director = thor.kmps.local-dir = all, !skipped, !restored

}Проверим на наличие ошибок и добавим в rc.conf для запуска при старте ОС.

# bacula-fd -t -d /usr/local/etc/bacula-fd.conf # echo 'bacula_fd_enable="YES"' >> /etc/rc.conf # /usr/local/etc/rc.d/bacula-fd start Starting bacula_fd. # sockstat | grep bacula root bacula-fd 9295 3 tcp4 *:9102 *:* bacula bacula-sd 97221 3 tcp4 *:9103 *:* bacula bacula-dir 97212 4 tcp4 *:9101 *:*

Загружаем программу клиент Win32_64 и запускаем установку программы там указываем следующее.

Тип установки:

Instalation Type: Automatic (так же вы можете поставить только fd без консоли и доков.)

Указываем характеристики DIR:

DIR name: thor.kmps.local-dir

DIR Password: SECRET

DIR Adress: thor.kmps.local

В конце установки предложили сохранить файл C:\srv2-fd.conf такого содержания:

# Client (File Services) to backup

Client {

Name = srv2-fd

Address = srv2.kmps.local

FDPort = 9102

Catalog = MyCatalog

Password = "MkfdcfGqds5qFoSL/W2uBG0DqIvY5bbVDWq/ZuHN39Ct" # password for FileDaemon

File Retention = 30 days # 30 days

Job Retention = 6 months # six months

AutoPrune = yes # Prune expired Jobs/Files

}

Для автоматического запуска DIR, SD и FD сервисов при запуске сервера необходимо добавить строчки в /etc/rc.conf:

# echo 'bacula_dir_enable="YES"' >> /etc/rc.conf # echo 'bacula_sd_enable="YES"' >> /etc/rc.conf # echo 'bacula_fd_enable="YES"' >> /etc/rc.conf

Запуск сервисов:

# /usr/local/etc/rc.d/bacula-dir.sh start # /usr/local/etc/rc.d/bacula-sd.sh start # /usr/local/etc/rc.d/bacula-fd start # ps -ax | grep bacula 2060 ?? Is 0:00,19 /usr/local/sbin/bacula-fd -u root -g wheel -v -c /usr/local/etc/bacula-fd.conf 56766 ?? Is 0:19,37 /usr/local/sbin/bacula-sd -u bacula -g bacula -v -c /usr/local/etc/bacula-sd.conf 61339 ?? Ss 0:00,14 /usr/local/sbin/bacula-dir -u bacula -g bacula -v -c /usr/local/etc/bacula-dir.conf 64965 0 S+ 0:00,00 grep bacula # sockstat | grep bacula bacula bacula-dir 61339 5 tcp4 *:9101 *:* bacula bacula-dir 61339 6 dgram -> /var/run/log bacula bacula-sd 56766 4 tcp4 *:9103 *:* root bacula-fd 2060 3 tcp4 *:9102 *:*

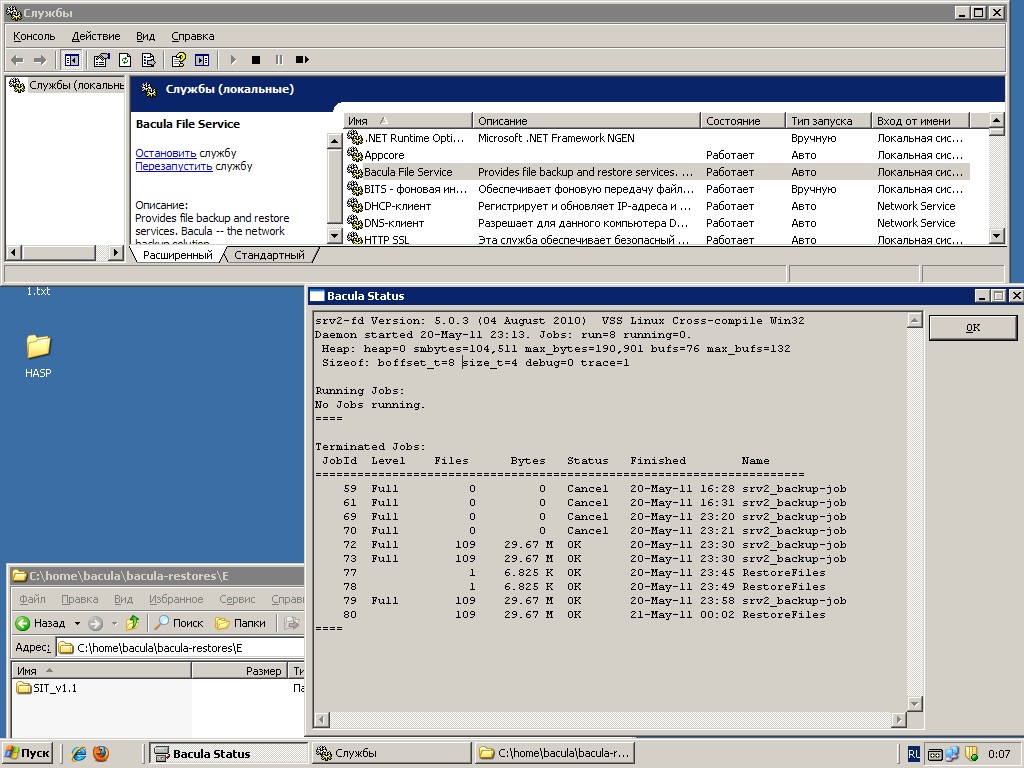

Автоматическое сохранение данных уже настроено и поэтому вы должны следить чтобы все работы шли без ошибок, проверять оставшееся место на HDD. Если вы выполните команду run без параметров она вам выдаст все созданные задачи и вы можете выбрать и запустить нужную. Вы можете сразу запустить нужную задачу с указанным именем задачи *run job=имя-задания.

*run

A job name must be specified.

The defined Job resources are:

1: BackupClient1

2: BackupCatalog

3: RestoreFiles

4: thor_backup-job

5: srv1_backup-job

6: srv2_backup-job

Select Job resource (1-6): 6

Run Backup job

JobName: srv2_backup-job

Level: Full

Client: srv2-fd

FileSet: srv2-fileset

Pool: srv2-pool (From Job resource)

Storage: File-SRV2 (From Job resource)

When: 2011-05-20 23:56:51

Priority: 10

OK to run? (yes/mod/no): yes

Job queued. JobId=79*status dir

thor.kmps.local-dir Version: 5.0.3 (04 August 2010) amd64-portbld-freebsd8.2 freebsd 8.2-

Daemon started 20-май-11 23:32, 5 Jobs run since started.

Heap: heap=0 smbytes=102,439 max_bytes=237,812 bufs=365 max_bufs=395

~~~~~~~~

Terminated Jobs:

JobId Level Files Bytes Status Finished Name

====================================================================

75 Full 831 717.5 M OK 20-май-11 23:34 srv1_backup-job

76 831 800.9 M OK 20-май-11 23:39 RestoreFiles

77 1 6.825 K OK 20-май-11 23:44 RestoreFiles

78 1 6.825 K OK 20-май-11 23:48 RestoreFiles

79 Full 109 29.67 M OK 20-май-11 23:57 srv2_backup-job

====И так с имитируем следующую ситуацию потеря\удаления файла\директории. Восстановим из архива данный файл с помощью bconsole. Директория E:/SIT_v1.1 утеряна вся.

Управление при перемещении и маркировки файлов в этом режиме довольно необычны так, что привыкайте.

*restore

Automatically selected Catalog: MyCatalog

Using Catalog "MyCatalog"

Сначала выберите один или несколько JobIds, которые содержат файлы

которые должны быть восстановлены. Вам будет предложен ряд методов

указания JobIds. Тогда вам будет разрешено выбрать, какие

файлы из этих JobIds должны быть восстановлены.

To select the JobIds, you have the following choices:

1: List last 20 Jobs run

2: List Jobs where a given File is saved

3: Enter list of comma separated JobIds to select

4: Enter SQL list command

5: Select the most recent backup for a client

6: Select backup for a client before a specified time

7: Enter a list of files to restore

8: Enter a list of files to restore before a specified time

9: Find the JobIds of the most recent backup for a client

10: Find the JobIds for a backup for a client before a specified time

11: Enter a list of directories to restore for found JobIds

12: Select full restore to a specified Job date

13: Cancel

Select item: (1-13): 1

+-------+--------------------+---------------------+----------+----------+-------------+

| JobId | Client | StartTime | JobLevel | JobFiles | JobBytes |

+-------+--------------------+---------------------+----------+----------+-------------+

| 79 | srv2-fd | 2011-05-20 23:56:55 | F | 109 | 29670528 |

| 75 | srv1-fd | 2011-05-20 23:32:37 | F | 831 | 717551775 |

| 74 | srv1-fd | 2011-05-20 23:30:46 | F | 0 | 0 |

| 73 | srv2-fd | 2011-05-20 23:29:24 | F | 109 | 29670528 |

| 72 | srv2-fd | 2011-05-20 23:26:51 | F | 109 | 29670528 |

+-------+--------------------+---------------------+----------+----------+-------------+

Для выбора JobIds, у вас есть следующие варианты [дальше лучше без перевода]:

1: List last 20 Jobs run

2: List Jobs where a given File is saved

3: Enter list of comma separated JobIds to select

4: Enter SQL list command

5: Select the most recent backup for a client

6: Select backup for a client before a specified time

7: Enter a list of files to restore

8: Enter a list of files to restore before a specified time

9: Find the JobIds of the most recent backup for a client

10: Find the JobIds for a backup for a client before a specified time

11: Enter a list of directories to restore for found JobIds

12: Select full restore to a specified Job date

13: Cancel

Select item: (1-13): 3

Enter JobId(s), comma separated, to restore: 79

You have selected the following JobId: 79

Building directory tree for JobId(s) 79 ... ++++++++++++++++++++++++++++++++

97 files inserted into the tree.

Сейчас вы работаете в режиме выбора файла, где вы добавляете (mark) и

удалять (unmark) файлы, котоfрые будут восстановлены. Нет изначально

добавленных файлов, вы можете использовать ключевое слов "all" в

командной строке чтобы отметить всё.

Введите "done ", чтобы завершить этот режим.

cwd is: /

$ ls

E:/

$ cd E:/

cwd is: E:/

$ ls

SIT_v1.1/

$ mark SIT_v1.1

109 files marked.

$ done

Bootstrap records written to /var/db/bacula/thor.kmps.local-dir.restore.4.bsr

The job will require the following

Volume(s) Storage(s) SD Device(s)

===========================================================================

srv2_volume File-SRV2 FileStorage-srv2

Volumes marked with "*" are online.

109 files selected to be restored.

Defined Clients:

1: srv1-fd

2: srv2-fd

3: thor-fd

4: thor.kmps.local-fd

Select the Client (1-4): 2

Run Restore job

JobName: RestoreFiles

Bootstrap: /var/db/bacula/thor.kmps.local-dir.restore.4.bsr